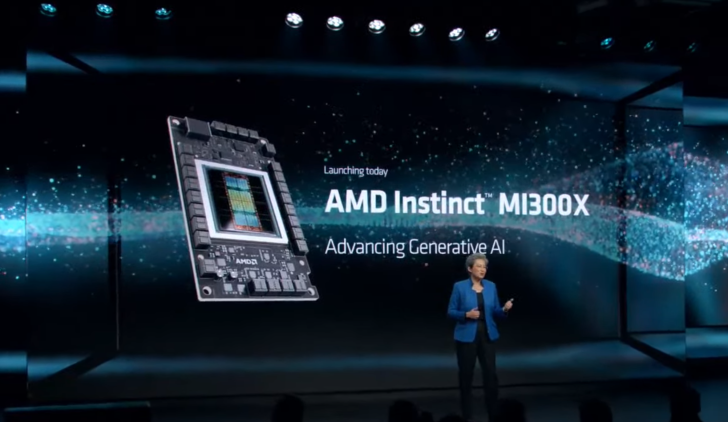

12月7日消息,AMD于当地时间周三举行了“Advancing AI”发布会,正式推出了面向AI及HPC领域的GPU产品Instinct MI300A/MI300X加速器,直接与英伟达(NVIDIA)H100加速器竞争。同时AMD还发布了代号为Hawk Point的最新一代Ryzen 8000系列APU,可面向AI PC产品。

AMD CEO苏姿丰表示,AI是50多年以来最重要、最具转变性的技术,不止是很酷的新玩意,也真切地是运算的未来。

苏姿丰说,AI在很短的时间内,不只是发展而已,更可谓是爆炸性成长。与其地位大约相近者,可能是互联网的发明,但不同的是,AI获采用的速度将会更快。现在还只是处于AI纪元发展的非常早期阶段。

苏姿丰预期,相较于目前的450亿美元规模,至2027年时,数据中心AI加速器市场的整体潜在市场规模(TAM)将达到4,000亿美元,年均复合成长率(CAGR)超过70%。

AMD共有三大AI策略,首先是具备完整IP与广泛的运算引擎产品组合,可支持从云端、边缘至终端,要求最严苛的工作负载。二是该公司正扩展软件能力,以降低进入与使用AI完整潜质的门坎。第三是该公司正在深化AI合作伙伴的产业体系,让云端服务供应商(CSP)、OEM与独立软件开发厂商(ISV)能享有其先驱性的创新技术。

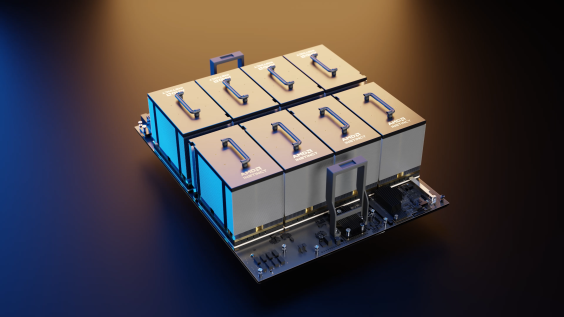

AMD在这次活动中推出了面向云端的AI芯片与AI笔记本电脑处理器。目前MI300A已经出货,MI300X也开始量产。苏姿丰强调,基于8颗MI300X的计算机是“世界上最强大的生成式AI计算机”。另外,AMD全新Ryzen 8040系列笔记本电脑处理器,也已开始供货,抢攻AI PC市场。PC厂商搭载Ryzen 8040系列的新机预计将从2024年第1季开始上市。

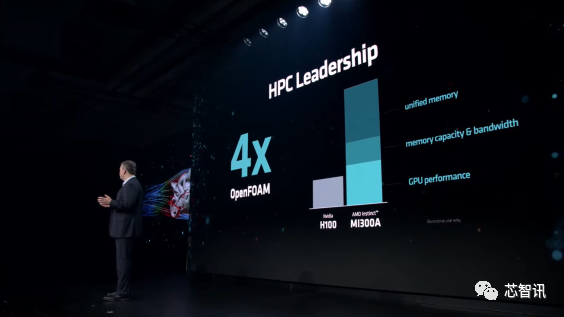

MI300A:HPC性能达到NVIDIA H100的4倍

虽然在今年6月的“数据中心与人工智能技术发布会”,AMD就有发布MI300A和MI300X,只不过当时MI300X只是纸面上的发布,现在MI300A和MI300X已经开始批量量产了,AMD也公布了更多关于MI300A、MI300X的性能数据。

AMD MI300A采用了Chiplet设计,其内部拥有多达13个小芯片,均基于台积电5nm或6nm制程工艺(CPU/GPU计算核心为5nm,HBM内存和I/O等为6nm),其中许多是 3D 堆叠的,以便创建一个面积可控的单芯片封装,总共集成1460 亿个晶体管。

具体来说,MI300A与上一代的MI250X一脉相承,采用新一代的CDNA 3 GPU架构,拥有228个计算单元(14592个核心),并集成了24个Zen 4 CPU内核,配置了128GB的HBM3内存。MI300A的计算核心被 8 个HBM3内存包围,单个HBM3的带宽为6.3GB/s,八个16GB堆栈形成128GB统一内存,带宽高达5.3 TB/s。

在算力方面,MI300A提供了高达61 TFLOPS FP64算力,多达122 TFLOPS FP32算力。

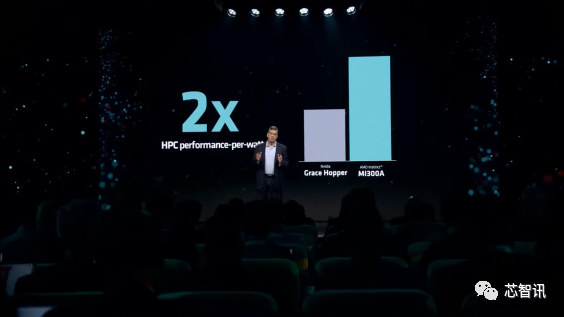

AMD表示,MI300A GPU将HPC提升到一个新的水平,其性能是NVIDIA H100的4倍,能效是H100的两倍。

具体来说,在OpenFOAM中,MI300A APU提供了相比H100高达4倍的性能提升,这主要来自于统一的内存布局、GPU性能以及整体内存容量和带宽。与NVIDIA的Grace Hopper超级芯片相比,该系统每瓦的性能也提高了2倍。

AMD证实,MI300A目前正在发货,还将用于为下一代El Capitan超级计算机提供动力,预计该超级计算机将提供高达2 Exaflops的计算能力。值得一提的是,AMD是唯一一家凭借Frontier超级计算机突破1 Exaflop大关的公司,也是地球上效率最高的系统。

MI300X:AI性能比英伟达H100高出30%!

12月7日消息,AMD于当地时间周三举行了“Advancing AI”发布会,正式推出了面向AI及HPC领域的GPU产品Instinct MI300X加速器,直接与英伟达(NVIDIA)H100加速器竞争。虽然在今年6月的“数据中心与人工智能技术发布会”,AMD就有发布MI300A和MI300X,只不过当时MI300X只是纸面上的发布,现在MI300X正式开始出货了,AMD也公布了更多关于MI300X的性能对比数据。

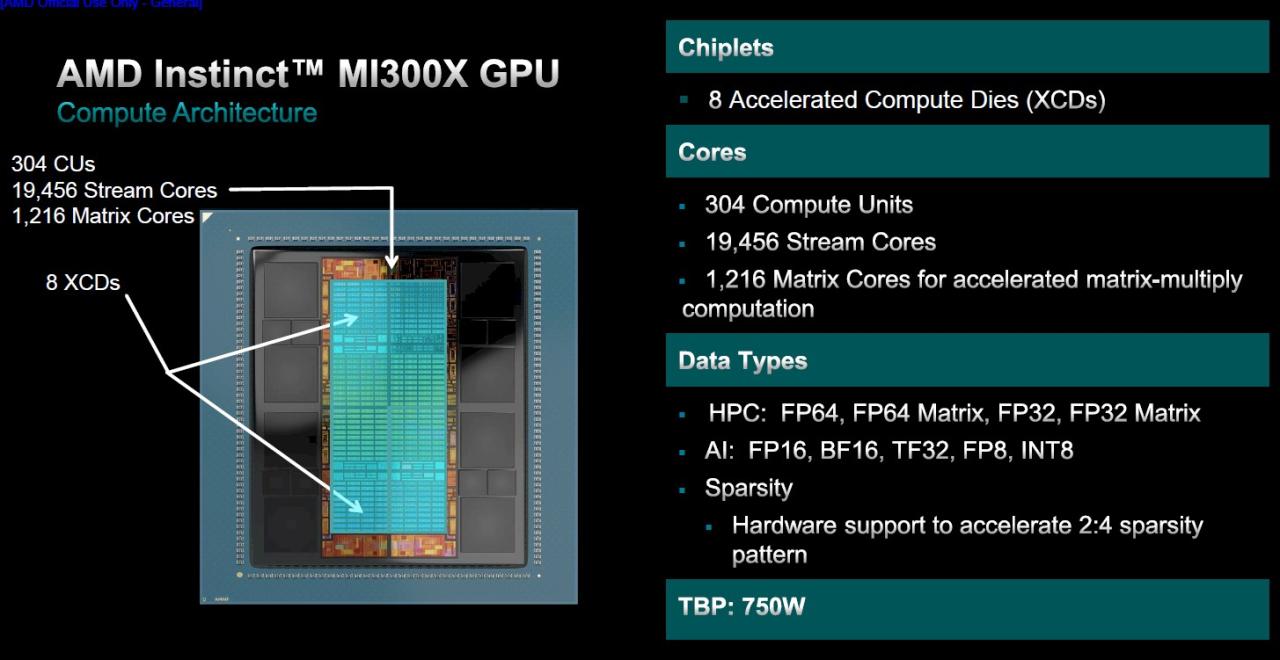

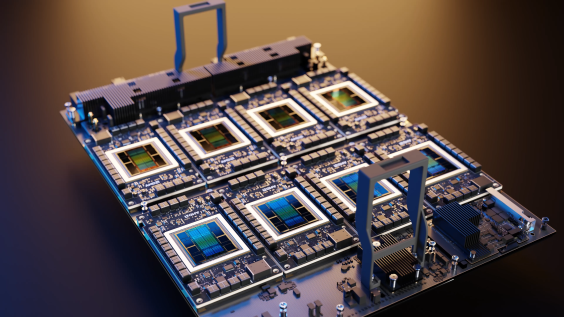

在硬件参数方面,MI300X内部集成了12个5/6nm工艺的小芯片(HMB和I/O为6nm),拥有1530亿个晶体管。在内核设计上,采用了相比MI250X更简单的设计,放弃了 APU 的 24 个Zen4内核和 I/O 芯片,取而代之的是更多计算核心的 CDNA 3 GPU。

MI300X的每个基于CDNA 3 GPU架构的XCD总共有八个计算芯片(XCD),每个计算芯片有40个计算单元,总共有320个计算单元,即20480个核心单元。不过,就目前的量产版而言,AMD缩减这些核心的一小部分,因此实际总共有304个计算单元(每个GPU小芯片38个CU)可用于19456个流处理器。

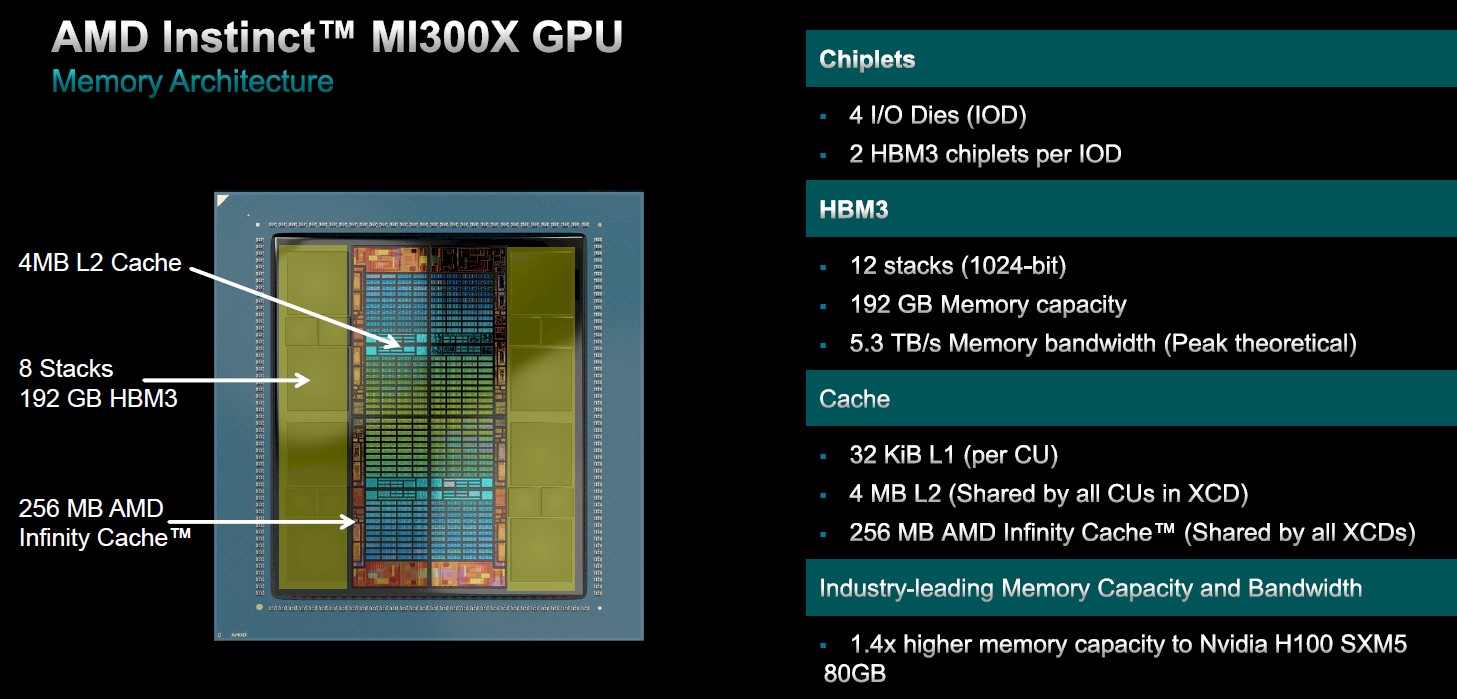

在内存带宽方面,MI300X也配备了更大的 192GB HBM3内存(8个HBM3封装,每个堆栈为12 Hi)相比MI250X提高了50%,带来高达5.3TB/s的带宽和896GB/s的Infinity Fabric带宽。相比之下,英伟达即将推出的H200 AI加速器提供141 GB的容量,而英特尔即将推出的Gaudi 3将提供144 GB的容量。大型内存池在LLM(大语言模型)中非常重要,LLM大多是与内存绑定的,AMD可以通过在HBM内存容量上的领先地位来提升器人工智能能力。

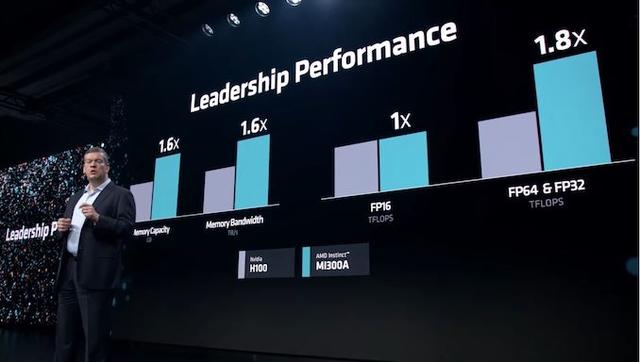

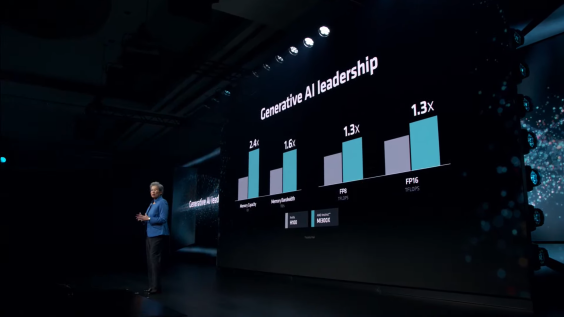

具体来说,AMD的MI300X与英伟达的H100加速器相比:

- 内存容量提高 2.4 倍

- 内存带宽提高 1.6 倍

- 1.3 倍 FP8 TFLOPS

- 1.3 倍 FP16 TFLOPS

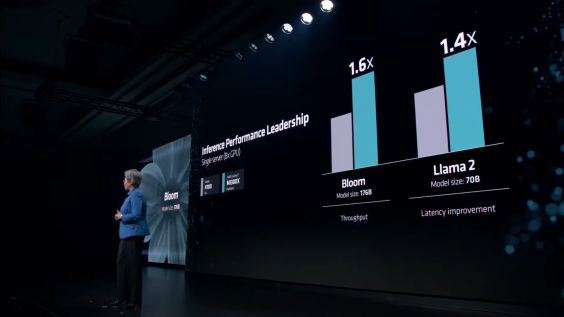

- 在 1v1 比较中,速度比 H100 (Llama 2 70B) 快达 20%

- 在 1v1 比较中,速度比 H100 (FlashAttention 2) 快达 20%

- 8v8 服务器中的速度比 H100 (Llama 2 70B) 快达 40%

- 在 8v8 服务器中,速度比 H100 (Bloom 176B) 快达 60%

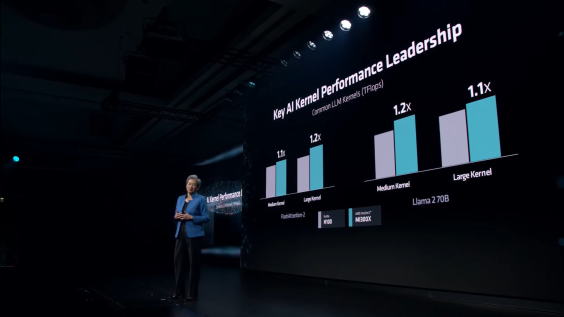

在具体的AI大模型加速性能对比当中,MI300X相比H100在 FlashAttention-2 和 Llama 2 70B 中提供了高达 20% 的性能提升。

从平台角度来看,将 8x MI300X 解决方案与 8X H100 解决方案进行比较,前者在 Llama 2 70B 中获得了更大的 40% 的性能提升,而在 Bloom 176B 中则获得了 60% 的性能提升。

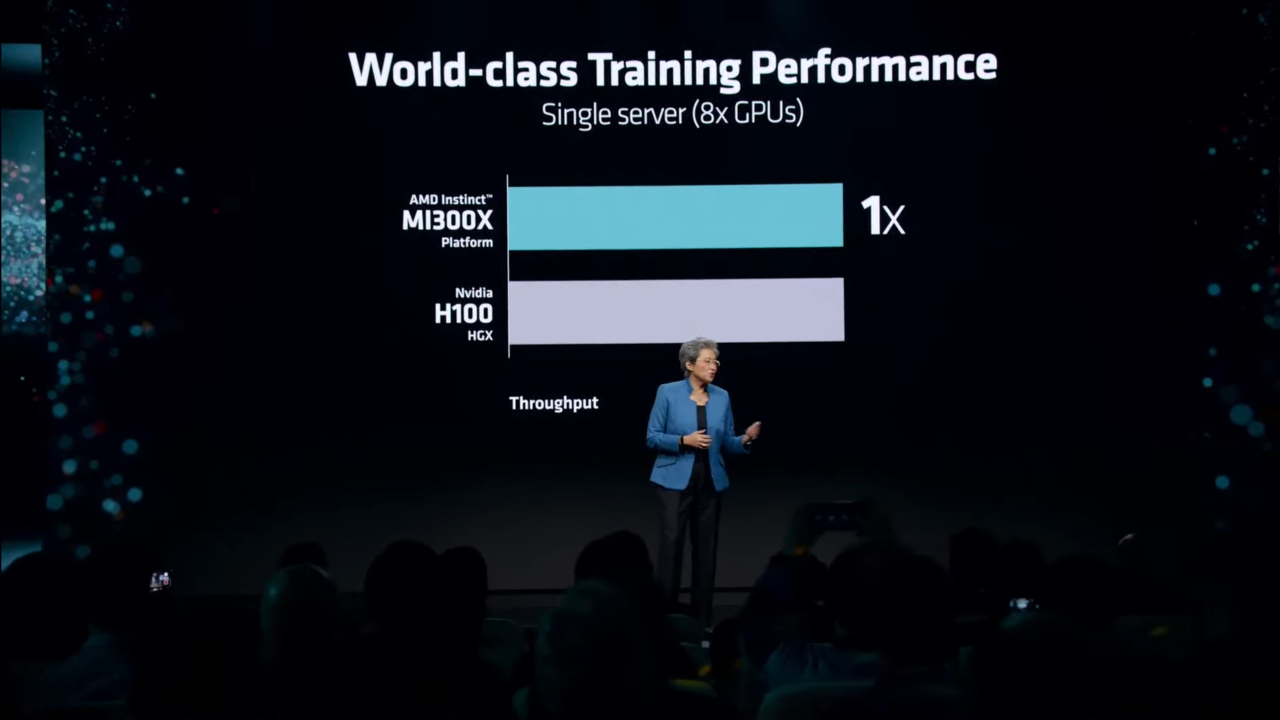

AMD指出,在AI训练性能方面,MI300X 与竞争对手 (H100) 相当,并提供有竞争力的价格/性能,同时在推理工作负载方面表现出色。

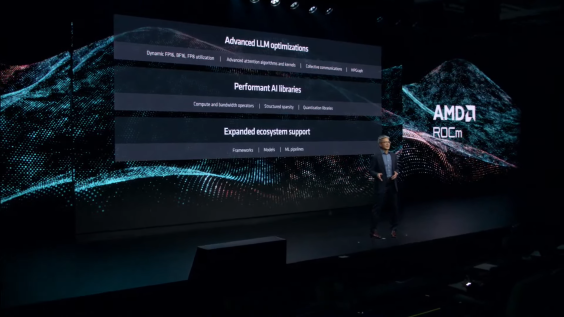

最新 MI300 加速器背后的驱动力是 ROCm 6.0。该软件堆栈已更新到最新版本,具有强大的新功能,包括支持各种人工智能工作负载,例如生成式人工智能和大型语言模型。

新的软件堆栈支持最新的计算格式,例如 FP16、Bf16 和 FP8(包括 Sparsity)等。

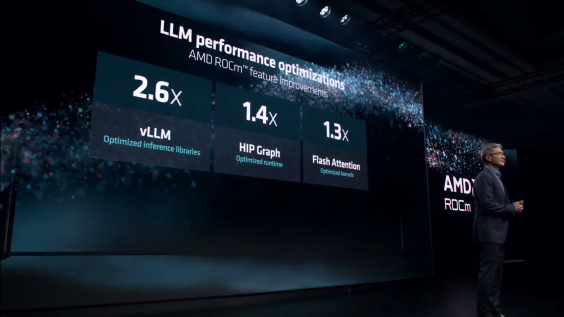

这些优化相结合,通过优化的推理库将 vLLM 的速度提高高达 2.6 倍,通过优化的运行时间将 HIP Graph 的速度提高 1.4 倍,并通过优化的内核将 Flash Attention 的速度提高 1.3 倍。

ROCm 6 预计将于本月晚些时候与 MI300 AI 加速器一起推出。看看 ROCm 6 与 NVIDIA CUDA 堆栈的最新版本(它的真正竞争对手)相比如何,将会很有趣。

在功耗方面,AMD MI300X的额定功率为750W,比 MI250X的500W增加了50%,比NVIDIA H200多了50W。

AMD还展示了一种配置是Gigabyte的G593-ZX1/ZX2系列服务器,它提供多达8个MI300X GPU加速器和两个AMD EPYC 9004 CPU。这些系统将配备多达八个3000W的电源,总功率为18000W。

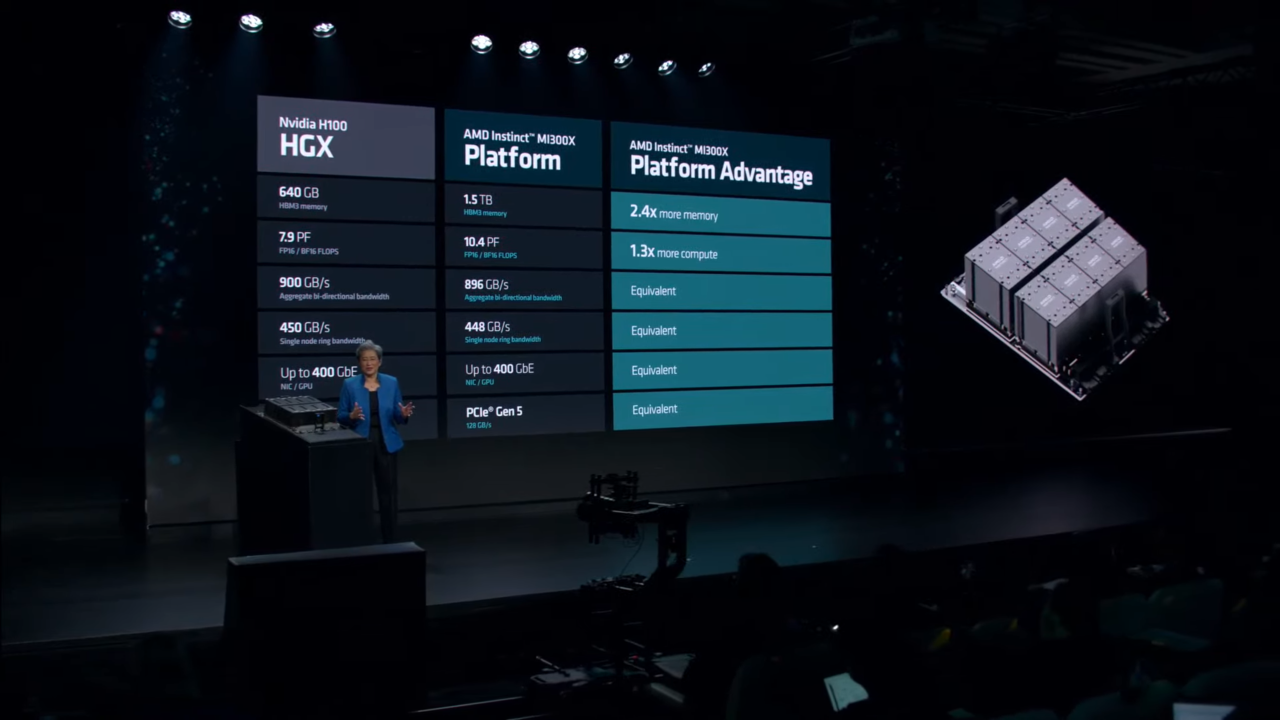

据介绍,该集成了8个MI300X GPU的加速器平台,相比NVIDIA HGX H100平台,带来的提升包括:

2.4倍更高的HBM3内存(1.5 TB vs. 640 GB)

1.3倍以上的计算FLOPS(10.4 PF vs. 7.9 PF)

类似的双向带宽(896 GB/s vs. 900 GB/s)

类似的单节点环形带宽(448 GB/s vs. 450 GB/s)

类似的网络功能(400 GbE vs. 400 GbE)

类似的PCIe协议(PCIe Gen 5 128 GB/s)

据semianalysis此前报道,微软、Meta、甲骨文、谷歌、Supermicro/Qunta-direct、亚马逊等公司已经向AMD下了不同数量的MI300系列订单。

今天,微软也宣布将评估对AMD的AI加速器产品的需求,评估采用该新品的可行性。Meta公司也宣布将在数据中心采用AMD新推的MI300X芯片产品。甲骨文也表示,公司将在云服务中采用AMD的新款芯片。

此前市场预计AMD的MI300系列在2024年的出货约为30~40万颗,最大客户为微软、谷歌,若非受限台积电CoWoS产能短缺及英伟达早已预订逾四成产能,AMD出货有望再上修。

值得注意的是,在不久前的财报会议上,AMD CEO苏姿丰(Lisa Su)表示,“基于我们在人工智能路线图执行和云客户购买承诺方面取得的快速进展,根据预计,随着全年收入的增加,数据中心GPU的收入在第四季度将约为4亿美元,2024年将超过20亿美元。这一增长将使MI300系列成为AMD历史上销售额最快增长至10亿美元的产品。

目前,在生成式AI的热潮之下,英伟达凭借其AI芯片的出色性能及CUDA的生态优势,在云端AI芯片市场占据者垄断优势。不过,由于英伟达的AI芯片价格高昂以及供应短缺,云服务及AI技术厂商们处于成本及多元化供应链安全考虑,也使得AMD和英特尔等竞争者有了更多的机会。

编辑:芯智讯-浪客剑