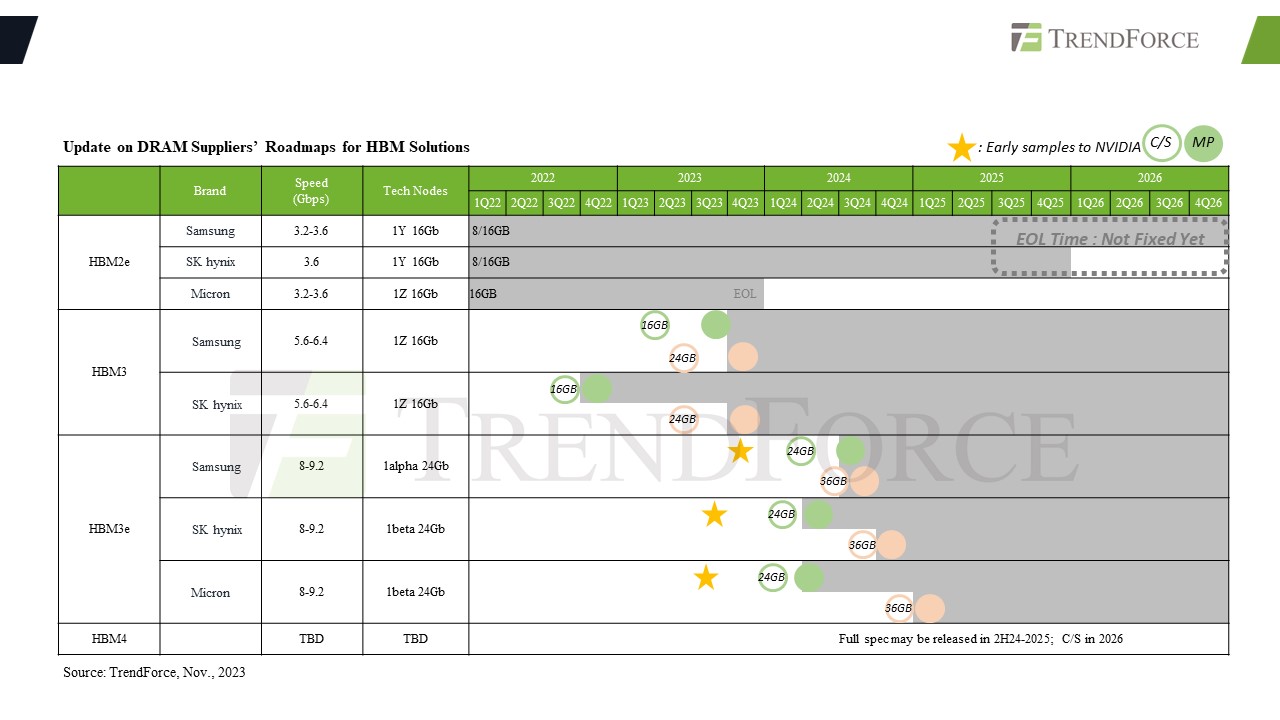

2月3日消息,据《韩国商报》报道,在近日的“SEMICON 韩国 2024”展会上,SK海力士副总裁Chun-hwan Kim透露,该公司HBM3内存已经量产,HBM3E将在今年上半年发布,并计划在 2026 年开始大规模生产 HBM4。

Chun-hwan Kim表示:“随着AI计算时代的到来,生成式人工智能(AI)正在迅速发展,市场预计将以每年35%的速度增长。”而生成式AI市场的快速增长则需要大量更高性能的AI芯片来支持,这也将进一步推动对于更高带宽的内存芯片的需求。

早在去年8月21日,SK海力士就宣布其开发出的HBM3e DRAM已经提供给英伟达(NVIDIA)和其他客户评估,并计划在2024年上半年量产,以巩固其在 AI 内存市场的领导地位。现在,Chun-hwan Kim宣布,该公司HBM3E内存已经正式量产。

据介绍,SK海力士的HBM3e在 1024 位接口上拥有9.6 GT/s 的数据传输速率,单个 HBM3E 内存堆栈可提供 1.2 TB/s 的理论峰值带宽,对于由六个堆栈组成的内存子系统来说,带宽可高达 7.2 TB/s。不过,该带宽是理论上的。例如,英伟达(Nvidia)的 H200所集成的HBM3e内存仅提供高达 4.8 TB/s的传输速率,可能是出于可靠性和功耗方面的考虑。

随着人工智能和高性能计算(HPC)行业的需求持续增长,因此具有2048位接口的下一代HBM4内存成为各家内存大厂发力的重点。

Chun-hwan Kim明确表示,SK海力士将在 2026 年开始生产HBM4,并声称这将推动人工智能市场的巨大增长。他认为,除了向下一代转型之外,重要的是要认识到HBM行业面临着巨大的需求。因此,创建一个既具有无缝供应又具有创新性的解决方案更为重要。Chun-hwan Kim认为,到 2025 年,HBM 市场预计将增长 40%,SK海力士已尽早定位以充分利用这一市场。

同样,美光和三星也计划在2026年量产HBM4。

据美光介绍,HBM4 将使用 2048 位接口,可以将每个堆栈的理论峰值内存带宽提高到 1.5 TB/s 以上。为了实现这一目标,HBM4 需要具有约 6 GT/s 的数据传输速率,这将有助于控制下一代 DRAM 的功耗。同时,2048 位内存接口需要在内插器上进行非常复杂的布线,或者仅将 HBM4 堆栈放置在芯片顶部。在这两种情况下,HBM4 都会比 HBM3 和 HBM3E 更昂贵。

三星内存执行副总裁 Jaejune Kim 在与分析师和投资者举行的最新财报电话会议上也表示:“HBM4 正在开发中,预计 2025 年提供样品,2026 年实现量产 。 ” “在生成式 AI 的推动下,对定制 HBM 的需求不断增长,因此我们不仅开发标准产品,而且还通过添加逻辑芯片为每个客户开发性能优化的定制 HBM。详细规格正在与关键产品讨论顾客。”

编辑:芯智讯-浪客剑