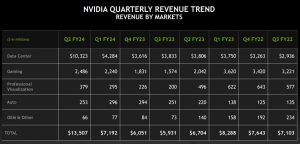

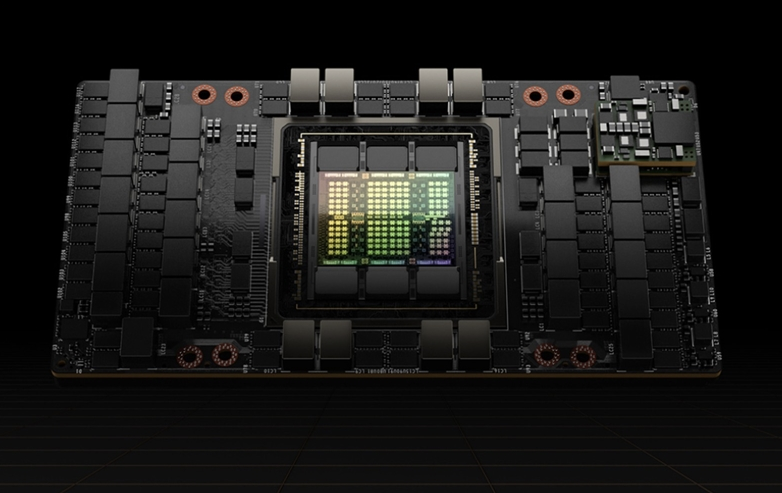

8月25日消息,昨日,英伟达(NVIDIA)发布了2024财年第二财季的财报显示,其数据中心业务营收达 103.2 亿美元,环比增长141%,同比增长171%。市场研究机构TrendForce 认为,NVIDIA 高营收成长动力来自数据中心 AI 服务器解决方案,主力产品有 AI 加速芯片GPU、AI服务器参考架构 HGX 等,均为大型数据中心的 AI 基础设施。

TrendForce预期,NVIDIA将进一步整合软硬件资源,更细致地将高阶及中低阶GPU AI加速芯片与各ODM或OEM绑定合作软硬件系统认证模式。除了加速CSP云端AI服务器基础设施建设,也和VMware等合作Private AI Foundation等方案,将触角延伸至边缘企业AI服务器市场,以支撑今明两年数据中心业务稳定成长。

Cloud AI强劲需求驱动,NVIDIA数据中心业务占比超过76%

NVIDIA近年来积极布局数据中心业务,在2022财年第四财季时,当时的数据中心业务在总营收当中的占比约42.7%,尚落后游戏业务营收约2个百分点,2023财年第一财季后正式超越游戏业务,占比逾45%。今年起各大CSP大举投资ChatBOT及公有云各种AI服务基础设施后,NVIDIA更直接受益,2024财年第二财季数据中心业务营收占比一举突破76%。

NVIDIA将进一步向云端及边缘数据中心AI应用市场扩展

TrendForce观察,预估NVIDIA高阶GPU产品销售策略,将于下半年后转变,原高阶AI服务器主打搭载A100及H100,市场需求大好下,改成主攻售价更高的H100,才能有效刺激数据中心营收向上。

中阶GPU方面,以近期L40s为主打方案,有几个策略意义。首先,高阶H100系列受限于CoWoS、HBM等产能有限,L40s搭配GDDR记忆体,不须要CoWoS封装,可加速导入中阶AI服务器市场,补足A100 PCIe接口对企业客户需求缺口。

其次,L40s也主攻企业客户,不需使用如ChatGPT庞大的参数模型,主攻较小型化(约数百亿至千亿参数量以下)各专业领域AI Training应用,亦针对边缘AI Inference或影像分析等使用。最后,中国客户因地缘政治问题,导致高阶H系列GPU供应受阻风险,可用L40s补足。低阶GPU系列以L4或T4系列为主打,边缘AI服务器即时AI推论或影像分析使用,并更强调较低价、高C/P值产品特性。

HGX及MGX等AI服务器参考架构是NVIDIA下半年主攻AI方案的利器

TrendForce观察,近期NVIDIA除对核心AI芯片GPU更细致化定位,也积极主推HGX及MGX等方案,这并不是服务器产业链首见作法,但NVIDIA有机会稳固领先利基。NVIDIA凭借高度整合GPU加上CUDA建立完整A I生态系,处于绝对领先位置,故对既有服务器供应链有较强议价能力,要求ODM如英业达、广达、工业富联、纬创、纬颖等,或品牌业者Dell、Supermicro、技嘉等,依NVIDIA HGX或MGX参考设计,且需经NVIDIA的AI服务器参考架构的软硬体认证。NVIDIA可整合兜售Arm CPU Grace及NPU或AI Cloud Foundation等软硬件解决方案。

值得注意的是,对ODM或OEM而言,预期NVIDIA今明两年云端服务业者AI服务器主力市场将大有斩获,有利拉抬整体AI服务器出货量及营收成长,但随着NVIDIA策略性导入HGX或MGX等标准化AI服务器架构,也使ODM等业者将因AI服务器核心产品架构较趋同质化使彼此争取CSPs等订单竞争态势更白热化。观察大型CSPs如Google、AWS有扩大导入自研ASIC AI加速芯片趋势,亦可能侵蚀部分NVIDIA GPU市场,使得NVIDIA持续推动不同定位GPU产品及整体方案,将AI业务积极拓展至Tier 2资料中心如CoreWeave等及边缘企业客户的主因之一。

编辑:芯智讯-林子