3月14日消息,面对火爆的AI市场,新创AI芯片公司Cerebras Systems近日推出了其第三代的晶圆级AI芯片WSE-3,性能达到了上一代WSE-2的两倍,将用于训练业内一些最大的人工智能模型。

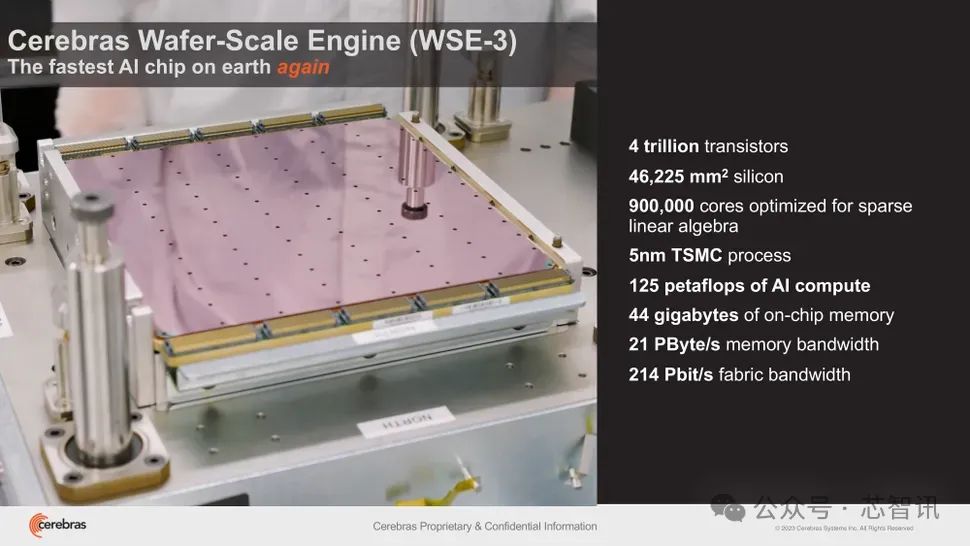

据介绍,WSE-3依然是采用了一整张12英寸晶圆来制作,基于台积电5nm制程,芯片面积为46225平方毫米,拥有的晶体管数量达到了4万亿个,拥有90万个AI核心,44GB片上SRAM,整体的内存带宽为21PB/s,结构带宽高达214PB/s。使得WSE-3具有125 FP16 PetaFLOPS的峰值性能,相比上一代的WSE-2提升了1倍。

作为对比,WSE-2芯片面积同样是46225平方毫米,基于台积电7nm制程,晶体管数量为2.6万亿个,AI内核数量为85万个,片上内存SRAM为40GB,内存带宽为20PB/s,结构带宽高达220PB/s。

如果将其与英伟达的H100相比,WSE-3面积将是H100的57倍,内核数量是H100的52倍,片上内存是H100的880倍,内存带宽是H100的7000倍,结构带宽是H100的3715倍。

与此同时,Cerebras还推出了基于WSE-3的CS-3超级计算机,可用于训练参数高达24万亿的人工智能模型,这比相比基于WSE-2和其他现代人工智能处理器的超级计算机有了重大飞跃。该超级计算机可以支持1.5TB、12TB或1.2PB的外部内存,这使它能够在单个逻辑空间中存储大量模型,而无需分区或重构,从而简化了训练过程,提高了开发人员的效率。

最新的 Cerebras 软件框架可以为PyTorch 2.0 和最新的 AI 模型和技术(如多模态模型、视觉转换器、专家混合和扩散)提供原生支持。Cerebras 仍然是唯一为动态和非结构化稀疏性提供本机硬件加速的平台,相比英伟达的DGX-100计算机系统,将训练速度提高了8 倍。

Cerebras还强调了CS-3卓越的电源效率和易用性。尽管性能翻了一番,CS-3仍保持着与前代产品相同的功耗。它还简化了大型语言模型(LLM)的训练,与GPU相比,所需代码减少了97%。例如,该公司表示,GPT-3大小的模型在Cerebras平台上只需要565行代码。

就可扩展性而言,CS-3可以配置在多达2048个系统的集群中。这种可扩展性使其能够在四个系统的设置下,在一天内微调700亿个参数模型,并在同一时间段内全面从头开始训练Llama 70B模型。

Cerebras表示,该公司已经看到了外界对CS-3的巨大兴趣,并有来自各个行业的大量订单积压,包括企业、政府和公有云厂商。Cerebras还与美国阿贡国家实验室和梅奥诊所等机构合作,强调了CS-3在医疗保健方面的潜力。

Cerebras和G42之间的战略合作伙伴关系也将随着Condor Galaxy 3的建设而扩大,这是一款人工智能超级计算机,拥有64个CS-3系统(拥有57600000个核心)。这两家公司已经共同创建了世界上最大的两台人工智能超级计算机:Condor Galaxy 1 (CG-1)和Condor Galaxy 2(CG-2),它们位于加利福尼亚州,综合性能为8个ExaFLOP。这一合作伙伴关系的目标是在全球范围内提供数十个exaFLOP的人工智能计算。

G42集团首席技术官Kiril Evtimov表示:“我们与Cerebras的战略合作伙伴关系有助于推动G42的创新,并将有助于加速全球范围内的人工智能革命。”。“Condor Galaxy 3是我们的下一台人工智能超级计算机,拥有8个exaFLOP,目前正在建设中,很快将使我们系统的人工智能计算总产量达到16个exafloP。”

相关文章:《Cerebras推出全球最强AI超算:5400万个AI内核,算力高达4 exaFLOPS!》

编辑:芯智讯-浪客剑