11月20日消息,英伟达(NVIDIA)推出的“Hopper”H100 GPU是目前全球AI巨头极力争夺的“战略资源”,但是由于供应量有限,很多订单都已经排到了2024年。这也迫使一些AI厂商选择考虑其他替代方案,当然H100高昂的价格也是一个影响因素。

对于那些想要购买替代产品,并控制自己的预算的厂商来说,这可能意味着需要去考虑购买AMD MI300X 和 MI300A GPU 、英特尔Gaudi 2 加速器,或者尝试购买一些 Nvidia A100 或 AMD MI250X,甚至去 Cerebras Systems、SambaNova Systems、Groq 或 Graphcore的产品。但是,这可能也意味着他们要支付 2.5 到 3 倍的费用才能在大型云上运行与H100所支持的同等大语言模型(LLM)。

或者,AI厂商可以构建一个集群,利用英伟达调整后的“Lovelace”L40S 加速器,并采用 Liqid 的可组合基础设施,以获得更高的 GPU 与 CPU 计算启动比率。假设AI厂商的 LLM 可以在没有太多 FP64 双精度浮点的情况下进行 AI 训练——显然,有些模型可以使用 FP32 和较低的精度,因为上面的奇特 AI 引擎根本没有任何 FP64算术。他们的部分工作负载因此而遭受性能下降,但他们通过其他方式弥补了这一点。(计算机架构总是需要权衡,不是吗?)

多年来,可组合基础设施供应商 Liqid 一直在强调可组合 GPU 机箱和将它们连接到集群中服务器的可组合 I/O 基础设施如何让公司能够在具有不同配置的不同工作负载之间共享 GPU,从而提高整体 GPU 利用率。这是一种从厂商们花费的 GPU 资金中获得更多工作效果的方法。但如今,您需要能够利用任何可用的 GPU 来完成大量工作。

早在 8 月初,英伟达就推出了基于 Lovelace AD102 的 L40S 加速器,Lovelace AD102 是同一 GPU 的被动冷却服务器芯片变体,被用于 RTX 5000 和 RTX 6000 显卡,以及用于 OVX Metaverse 平台的 L40 CPU 计算引擎,早在 2022 年 9 月就宣布了。

值得注意的是,Liqid 在上周的 SC23 超级计算大会上推出了基于 L40S 加速器的UltraStack 系统。

L40S 被英伟达称为“通用数据中心 GPU”,这大概是因为它可以驱动图形以及 32 位和更低精度的计算。具体来说,L40S 是 L40 的变体,已在更广泛的服务器上获得认证,并且经过认证可以运行 AI 训练和推理工作负载。而L40仅针对AI推理。

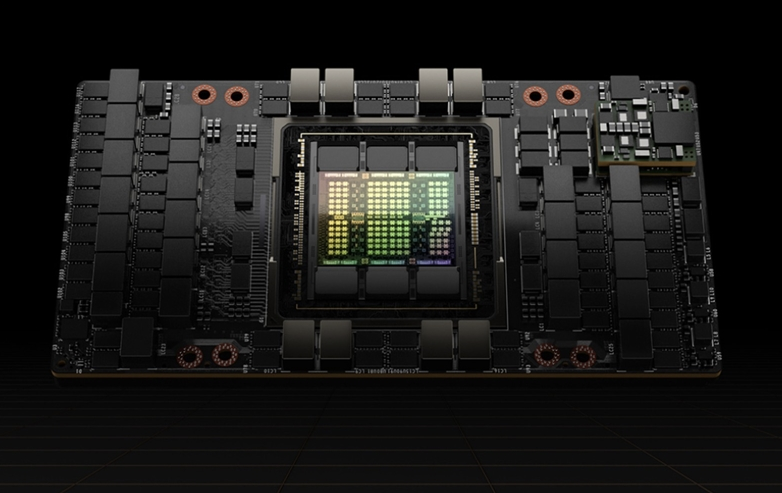

L40S 封装具有单个 AD102 GPU 和 48 GB GDDR6 帧缓冲内存,可提供 864 GB/秒的内存带宽和 91.6 teraflops 的 FP32 性能,在 AD102 中的 Tensor Core 上使用 NVIDIA TF32 格式时可提供 183 teraflops 的 FP32 性能,并在 Tensor Core 上提供稀疏支持,达到 366 teraflops 的性能。如果您想达到低精度限制,那么 L40S 可以在 FP8 下达到 733 teraflops,并在激活稀疏支持的情况下将其提高一倍,达到 1.47 petaflops。它可以以相同的速率驱动 INT8 和 INT4 数据。在仿真模式下运行的矢量内核上,FP64 的运算速度仅为区区 1.4 teraflops。

相比之下,最初的 Hopper H100 SXM5 设备具有 80 GB 的 HBM3 内存和 3.35 TB/秒的内存带宽,在稀疏性的 TF32 模式下,其向量可提供 67 teraflops 的 FP32 原始性能,其张量核心可提供 989 teraflops 的性能。 FP8 或 INT8 格式(启用稀疏性)为 3.96 petaflops。

L40S 的性能与 H100 相比并不容易衡量,但总的来说,在 NVIDIA 所说的 AI 工作负载方面,与 A100 相比,L40S 的性能要好 1.2 倍到 1.7 倍。

Liqid 产品和技术营销执行总监 George Wagner 告诉The Next Platform,在各种人工智能训练和推理工作负载上,H100 的性能是 L40S 的 2 到 3 倍,但 H100 消耗的电量是 L40S 的两倍,且成本约为 3 倍。而且,重要的是,现在还没有足够可用的供应。如果您想要H100,现在需要等待大约六个月的时间。

这就是为什么人们一直在求助于 Liqid,希望利用其可组合基础设施将更多 Lovelace GPU 加速器塞进系统中,而 NVIDIA 在 HGX 系统板上设计的 HGX 系统板则销售给基于 Hopper GPU 的 OEM 和 ODM,也用于其自己的 DGX 系统。

“三年多以来,我们一直在谈论可组合性的好处,”瓦格纳说。“我们拥有围绕软件提供性能、灵活性和效率的整个方法。我们发现有一群客户只是想要性能,这并不奇怪,真的。我们有一位客户告诉我们,他购买 Liqid 产品只是因为他可以在服务器后面放置 20 个 GPU 并满足他的性能要求,事情就这样结束了。他有钱,他需要结果。”

好消息是,借助可扩展 PCI-Express 总线并将其虚拟化的 Liqid 结构,该公司可以将 8 到 16 个 L40S GPU 连接到单个服务器。如果您需要的话,Liqid 可以进一步推动它。

Liqid 最初的 UltraStack 服务器是与戴尔联合打造的,基于其 2U 机架式 PowerEdge R760xa 服务器,该服务器使用英特尔的“Sapphire Rapids”Xeon SP 处理器。

UltraStack 包括其中一台 PowerEdge R760xa 服务器,搭配 Liqid Director 管理控制台和 Liqid PCI-Express 光纤交换机,以及三个扩展单元,最多可容纳 16 个 L40S GPU、最多 16 个 Liqid“Honey Badger”4 TB NVM - Express闪存驱动器。NVIDIA 的单个 BlueField-3 DPU 具有一对 200 Gb/秒端口,用于网络上的南北向流量,外壳中有八个双端口、200 Gb/秒 ConnectX-7 NIC,用于将 GPU 相互绑定跨多个外壳组。

以下是 UltraStack-x8 和 UltraStack-x16 机器的配置方式:

以下是 UltraStack 设置与仅购买四台带存储和每个盒子中四个 L40S GPU 的 2U 服务器(这是标准方式)的比较:

由于 L40S 计算引擎通过 PCI-Express 结构直接相互连接,UltraStack 的性能提高了 35%,而且当从四台 X86 主机服务器减少到一台时,功耗降低了 35%,这是无可争议的。软件许可成本降低了 75%,总体拥有成本降低了 25%。

所有这些都没有考虑到可组合性带来的任何好处。现在没有人有时间这样做。但如果他们购买Liqid系统,他们基本上会免费获得它,并且很容易就能弄清楚如何使用它。

编辑:芯智讯-林子 来源:The Next Platform