5月2日消息,AI芯片大厂英伟达 (NVIDIA) 计算业务副总裁 Manuvir Das在参加美国当地时间5月1日由MIT Technology Review 举行的 Future Compute 活动上,正式宣布DGX H100系统开始出货。客户将可以采用NVIDIA最新 AI 超级电脑提升制造、医疗照护、机器人等生成式AI应用需求。

NVIDIA表示,日本、厄瓜多和瑞典客户都将采用 NVIDIA DGX H100 系统,如 AI 工厂的生产数据,创建提供金融、医疗、法律、IT 和电信产业等基于 AI 洞见的服务,并致力协助产业转型。比如,可以预测工厂设备老化程度,以提升效率。

比如Green Physics AI 系统,可将物体碳足迹、年龄和能源消耗等信息加入号称制造业最大数据库的 SORDI.ai,让制造业者开发强大 AI 模型,并创建最佳化工厂和仓库效率的数位孪生。使用 Green Physics AI,可为产品和零组件最佳化能源利用和减少 CO2 排放。

即使不是世界一流研究机构或 500 大企业,也可使用 DGX H100。很多新创公司已经启用第一批生成式 AI 系统,驾驭生成式 AI 浪潮。伦敦和纽约的 Scissero 使用 GPT 驱动的聊天机器人提高法律流程效率,Scissero GPT 可起草法律文件,产生报告并做研究。德国 DeepL 使用多个 DGX H100 系统扩展提供客户几十种语言翻译服务,包括日本最大出版社 Nikkei。DeepL 最近推出 DeepL Write AI 写作助理。

许多 DGX H100 系统也能促进医疗保健并改善疗效。比如DGX H100已经成为东京 Tokyo-1 超级电脑的一部分,模拟加速药物开发。日本最大企业之一的三井物产株式会社于2021年11月成立的新创AI公司Xeureka也采用了DGX H100系统。德国、以色列和美国医院和学术医疗机构都是DGX H100 系统首批用户。

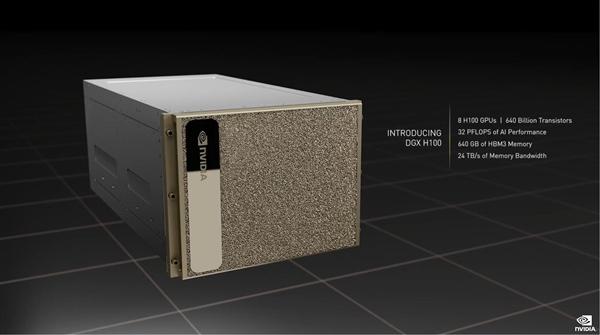

DGX H100系统搭载了8个最新的NVIDIA H100 GPU, 该GPU基于台积电4nm工艺,CoWoS 2.5D晶圆级封装,单个芯片集成了多达800亿个晶体管(比上一代A100多了260亿个),号称世界上最先进的芯片。这8个 H100 GPU通过NVIDIA NVLink技术互连,再搭配两颗PCIe 5.0 CPU处理器,可拥有总计6400亿个晶体管、640GB HBM3显存、24TB/s显存带宽。

性能方面,DGX H100系统的AI算力高达32PFlops(每秒3.2亿亿次),浮点算力FP64 480TFlops(每秒480万亿次),FP16 1.6PFlops(每秒1.6千万亿次),FP8 3.2PFlops(每秒3.2千亿次),分别是上代DGX A100的3倍、3倍、6倍,而且新增支持网络内计算,性能可达3.6TFlops。

DGX H100系统在 NVIDIA Base Command 上运行,后者是加速运算、储存和网络基础设施并最佳化 AI 负载的套件。DGX H100 系统还包括 NVIDIA AI Enterprise 软件,可加速数据科学流程,并简化生成式 AI、计算机视觉等开发部署。DGX H100平台还具高效能和高效率特性,与上一代的 DGX A100 相比,DGX H100 每 petaflop 运算力的能源效率提高了原来的2倍。

另外,使用 400 Gbps 超低延迟的 NVIDIA Quantum InfiniBand 还可将数百个 DGX H100 节点连线一台 AI 超级电脑。

值得一提的是,为了让更多的中小企业用得起DGX H100系统,NVIDIA此前还推出了云端人工智能专用的 NVIDIA DGX AI超级计算集群DGX Cloud。

据介绍,每个DGX Cloud实例都具有8个H100或A100 80GB Tensor Core GPU,每个节点共有640GB GPU内存。使用NVIDIA Networking构建的高性能、低延迟结构确保工作负载可以跨互连系统集群扩展,允许多个实例充当一个巨大的GPU,以满足高级AI训练的性能要求。并配备了NVIDIA AI软件,用户能够按月租用这些计算资源,只需使用简单的网络浏览器即可访问。这将消除在本地获取、部署和管理基础设施的成本,大大增加了AI能力获取的便捷性。

NVIDIA将与云服务提供商合作托管DGX云基础设施,每个DGX Cloud实例的月租价格定为36999美元起。

编辑:芯智讯-浪客剑