3月23日消息,当地时间22日,图形处理器大厂英伟达(NVIDIA)的2022年度GTC大会正式开幕,英伟达CEO黄仁勋在主题演讲环节正式发布针对数据中心的新一代Hopper架构的GPU芯片NVIDIA H100,同时发布的还有基于新核心的加速计算卡“H100”、AI计算系统“DGX H100”。此外还有英伟达自研的服务器处理器Grace CPU。

全新Hopper架构H100 GPU:台积电4nm工艺,800亿个晶体管

据介绍,NVIDIA H100采用了台积电最新的4nm工艺,而且是定制版,CoWoS 2.5D晶圆级封装,单芯片设计,集成多达800亿个晶体管(比上一代A100多了260亿个),号称世界上最先进的芯片。

H100完整版有8组GPC(图形处理器集群)、72组TPC(纹理处理器集群)、144组SM(流式多处理器单元),而每组SM有128个FP32 CUDA核心,总计18432个核心。显存支持六颗HBM3或者HBM2e,控制器是12组512-bit,总计位宽6144-bit。Tensor张量核心来到第四代,共有576个,另有60MB二级缓存。

扩展互连支持PCIe 5.0、NVLink第四代,后者带宽提升至900GB/s,七倍于PCIe 5.0,相比A100也多了一半。整卡对外总带宽4.9TB/s。

性能方面,FP64/FP32 60TFlops(每秒60万亿次),FP16 2000TFlops(每秒2000万亿次),TF32 1000TFlops(每秒1000万亿次),都三倍于A100,FP8 4000TFlops(每秒4000万亿次),六倍于A100。

内核数量则飙到了前所未有的16896个,达到上一代A100卡的2.5倍。浮点计算和张量核心运算能力也随之翻了至少3倍,比如FP32就达到了达到60万亿次/秒。不过它的功耗也达到了惊人的700W。

英伟达强调,基于全新Hopper 架构的H100 GPU 为加速大规模AI 及高效能运算树立了新标准,并带来六项突破性创新:

1. H100 拥有800 亿个晶体管,采用台积电4N (4nm)工艺制程、专为满足NVIDIA 加速运算需求而设计,在AI加速、高效能计算、内存带宽、互连和通信方面具有重大进展,包括每秒近5TB 的外部连接速度。H100 是首款支援PCIe Gen5 及首款使用HBM3 的GPU 产品,提供每秒3TB 的带宽。20 个H100 GPU 便足以支撑全世界的网络流量,让客户得以运行先进的推荐系统和大型语言模型,即时使用各项数据进行推论。

2. Transformer 已是自然语言处理的首选标准模型,是史上最重要的深度学习模型之一。相较于前一代产品,H100 加速器的Transformer Engine 能够将这些网路的速度提高六倍,又不失其精度。

3. 多执行个体GPU (Multi-Instance GPU;MIG) 技术可以将一个GPU 分割成七个较小、完全隔离的执行个体以处理各类工作。Hopper 架构在云端环境里为每个GPU 执行个体提供安全的多租户配置,将MIG 的能力较前一代扩大高达七倍。

4. H100 是全球首款具有安全运算能力的加速器,可以在处理AI 模型和客户数据时加以保护。对于医疗和金融服务等对隐私极为敏感的产业,在进行联邦学习时同样能运用安全运算,在共享的云端基础设施上也同样可行。

5. 为加快最大型AI 模型的运作速度,以NVLink 搭配全新的外部NVLink 交换器,将NVLink 当成伺服器以外的垂直扩展网路,相较于使用NVIDIA HDR Quantum InfiniBand 的前一代产品,能以超过9倍的频宽连接多达256 个H100 GPU,即带宽速度达到900GB/s。

6. 与使用CPU 相比,全新DPX 指令将用于众多算法(包括路线最佳化及基因组学) 的动态规划执行速度加快高达40 倍;而与使用前一代的GPU 相比,速度加快了七倍。这包括为动态仓库环境中的自主机器人车队寻找最佳路线的Floyd-Warshall 算法,以及用于DNA 和蛋白质分类及折叠的序列比对Smith-Waterman 算法。

英伟达进一步指出,H100 的多项技术创新扩大了其在AI 推论和训练的领先地位,使英伟达能够利用巨大的AI 模型做到即时和沉浸式应用。H100 让聊天机器人可以使用全球最强大的单体transformer 语言模型Megatron 530B,其传输量超过前一代产品达30 倍,同时满足即时对话式AI 所需的次秒级延迟。H100 同时让研究人员和开发人员能够训练像是Mixture of Experts 这类大规模模型,包含3,950 亿个参数,能将速度提高达9倍,将训练时间从过去所需的数周减少到数日便能完成。

英伟达CEO黄仁勋表示,这款以美国电脑科学家先驱Grace Hopper命名的全新GPU架构,是为了推动下一波AI数据中心的发展,效能较上一代Ampere架构的GPU平台呈指数级成长。而基于新的Hopper架构的首款GPU产品NVIDIA H100,则是目前全球最强大的加速器,可用于推动极大规模的AI语言模型、深度推荐系统、基因组学和复杂的数字孪生等领域的发展。

预计2022 年第三季,H100可通过全球各大云端服务供应商及电脑制造商供货,也可以直接向英伟达购买。

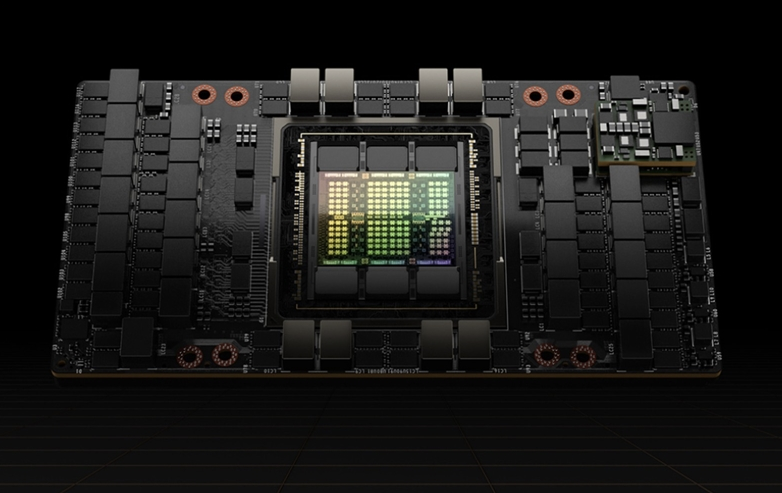

H100加速卡

H100加速卡采用SXM、PCIe 5.0两种形态,其中后者功耗高达史无前例的700W,相比A100多了整整300W。

按惯例也不是满血,GPC虽然还是8组,但是SXM5版本只开启了62组TPC(魅族GPC屏蔽一组TPC)、128组SM,总计有15872个CUDA核心、528个Tensor核心、50MB二级缓存。

PCIe 5.0版本更是只有57组TPC,SM虽然还是128组,但是CUDA核心只有14952个,Tensor核心只有456个。

同时,英伟达还将推出一款融合加速器,将H100 GPU 搭配NVIDIA ConnectX-7 400Gb/s InfiniBand 及Ethernet SmartNIC。而H100可以部署在各类型的数据中心内,包括企业内部、云端、混合云和边缘。

Connect TX-7网络互连芯片基于台积电7nm工艺,800亿个晶体管,400G GPUDirect吞吐量,400G加密加速,4.05亿/秒信息率。

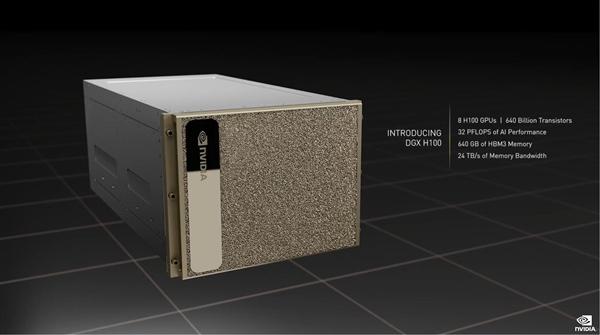

DGX H100系统

英伟达还宣布推出了第四代NVIDIA DGX H100系统,这也是全球首款搭载全新NVIDIA H100的AI平台,新一代系统提供的运算规模足以满足大型语言模型、推荐系统、医疗研究及气候科学等领域所需进行的海量运算。每个系统搭载8个H100 GPU,并通过NVIDIA NVLink技术互连。

凭借DGX H100系统集成的8颗H100芯片,再搭配两颗PCIe 5.0 CPU处理器,可拥有总计6400亿个晶体管、640GB HBM3显存、24TB/s显存带宽。

性能方面,AI算力32PFlops(每秒3.2亿亿次),浮点算力FP64 480TFlops(每秒480万亿次),FP16 1.6PFlops(每秒1.6千万亿次),FP8 3.2PFlops(每秒3.2千亿次),分别是上代DGX A100的3倍、3倍、6倍,而且新增支持网络内计算,性能3.6TFlops。PCIe 5.0版本的性能基本都再下降20%。

黄仁勋称,DGX H100系统是下一代NVIDIA DGX POD及DGX SuperPOD的AI基础设施平台的基石。

最新的DGX SuperPOD架构搭载全新NVLink交换器系统,可以连接多达32个节点上总共256个H100 GPU,也就是整合了256颗H100芯片。此外,“DGX POD”系统内,还有20.5TB HBM3内存,总带宽768TB/s,AI性能高达颠覆性的1EFlops(100亿亿亿次每秒),实现百亿亿次计算。

据介绍,该系统合作伙伴包括Atos、思科、戴尔、富士通、技嘉、新华三、慧与、浪潮、联想、宁畅、超威。云服务合作伙伴包括阿里云、亚马逊云、百度云、Google云、微软Azure、甲骨文云、腾讯云。

144核Grace CPU,挑战英特尔服务器处理器市场地位

在此次GTC 2022大会上,英伟达还正式宣布推出了首款自研的针对人工智能(AI) 基础架构与高效能运算所设计的数据中心处理器──Grace CPU。英伟达称,与当今顶尖的服务器处理器相比,其可提供最高的效能表现,以及两倍的内存带宽与能源使用效率。

据介绍,Grace CPU基于基于Arm Neoverse 架构设计,并由两个 CPU 芯片组成,并通过全新高速、低延迟、芯片到芯片互连的 NVLink-C2C 进行连接。有点类似苹果最新推出的M1 Ultra。总共有 144 个核心。

而Grace CPU与英伟达在2021年宣布推出的首款 CPU-GPU 整合模组 Grace Hopper 超级芯片相得益彰,该模组是为搭配 NVIDIA Hopper 架构 GPU 使用所设计,并共同支持大规模高效能运算及 AI 应用。这两款超级芯片皆使用相同的底层 CPU 架构与 NVLink-C2C 互连技术。

黄仁勋表示,随着全新型态的AI数据中心的出现,这款集最高效能、内存带宽和 NVIDIA 软体平台于一身的 Grace CPU 超级芯片,将作为全球 AI 基础架构的 CPU 而大放异彩。

NVIDIA强调,Grace CPU 超级芯片旨在提供最佳的效能表现,其单一CPU搭载 144 个 Arm Neoverse核心,并在 SPECrate2017_int_base 基准测试中获得领先业界的 740 分预估效能。与目前随 DGX A100 出货的双 CPU 相比,其效能表现高出超过 1.5 倍,这是英伟达实验室使用同级编译器估算的结果。

另外,Grace CPU 超级芯片亦可提供领先业界的能源使用效率和内存带宽,其创新的内存子系统由带有纠错码的 LPDDR5x 内存组成,在速度与功耗间取得最佳平衡。LPDDR5x 内存子系统以 1 TB/s 的速度,提供较传统 DDR5 设计的两倍带宽,同时大幅降低整个 GPU 的功耗,包括仅消耗 500 瓦的内存。而且,基于最新的Arm v9数据中心架构的Grace CPU 超级芯片将最高的单执行绪核心效能,结合支持 Arm 新一代的向量扩充指令集,将立即为许多应用程序带来优异的效能表现。

而 Grace CPU超级芯片将可运行 NVIDIA 的所有运算软件堆叠,包括 NVIDIA RTX、NVIDIA HPC、NVIDIA AI 和 Omniverse。Grace CPU 超级芯片搭配 NVIDIA ConnectX-7 NIC,可以弹性配置到服务器中,作为独立的纯 CPU 系统,或搭载一个、两个、四个或八个采用 Hopper 架构GPU 的 GPU 加速服务器,客户便能按照特定的作业负载进行最佳化调整效能,同时保持单一的软体堆叠。

NVIDIA进一步强调,当前高效能运算应用程序为密集运算、需使用最高效能核心、最高内存带宽与适合每个核心的内存容量,来加速运算结果。因此,NVIDIA 的Grace CPU 超级芯片的 144 个核心和 1TB/s 的内存带宽,将为以 CPU 为基础的高效能运算应用程式提供前所未有的效能。

现阶段,NVIDIA 正与顶尖的高效能运算、超级运算、超大规模与云端客户就 Grace CPU 超级芯片展开合作。Grace CPU 超级芯片与 Grace Hopper 超级芯片预计将于 2023 年上半年上市。

编辑:芯智讯-浪客剑