11月23日,由上海临港经济发展(集团)有限公司主办,临港科技、ASPENCORE承办的“2023中国临港国际半导体大会”在上海临港正式召开。中国半导体行业协会lC设计分会理事长、清华大学集成电路学院教授魏少军博士在会议上做了题为《智能化助力半导体产业发展》报告。

以下为芯智讯独家整理的魏少军教授演讲的主要内容:

人工智能延伸人类的认知能力

首先我们看一下人工智能它的这一次它主要解决什么问题?我们知道人类社会已经经过了三轮的转化了,第一次是在上世纪的40年代中期,主要是通用计算装置出现,是电子计算机的诞生。

那么第二次是在1990年,主要是以日本的第五代计算机作为一个标志,使用手工知识库和规则库做逻辑判断。

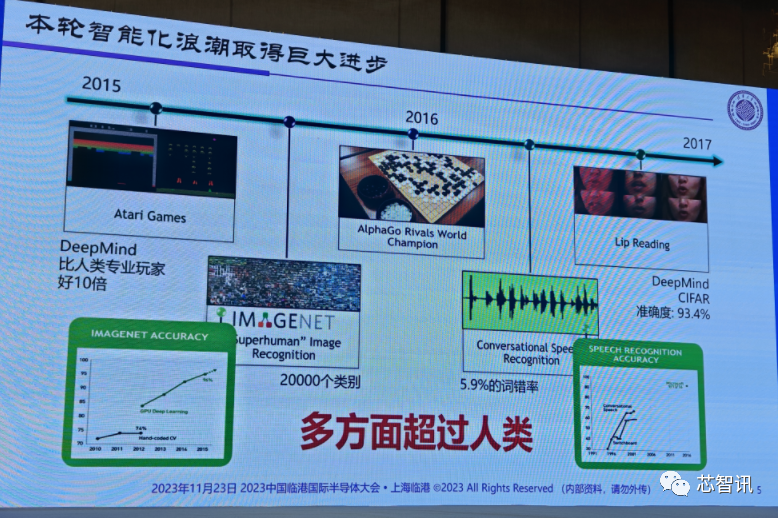

那么2017年开始的第三次浪潮主要是机器学习,应该说前两轮还是在做一些准备,但这一轮开始出现新本质上的变化。比如说谷歌的Deepmind它在人脸识别2万个类别当中,它的识别率超过了人类。此外,一些人工智能企业在语音的识别上,它的错词率也低于了6%。在语音识别上,我们国内科大讯飞也做得很不错,经常会看到一个讲演者在台上讲,旁边很快就把他的讲演中文稿会显示出来,那么英文稿也几乎在同时也被翻译出来。虽然还有些错字,但是总体而言准确率还是比较高。因此我们可以说这次的智能化浪潮使得人工智能在一些方面已经超过人类,以前还是没有超过人类。

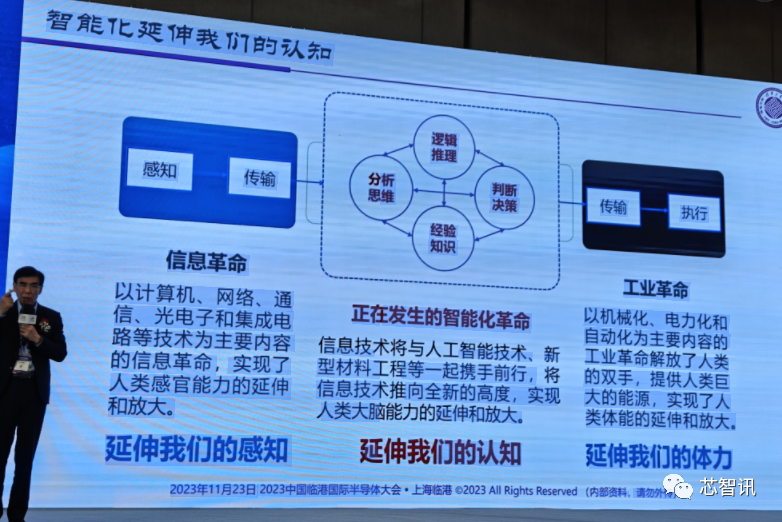

我们知道其实我们人在碰到问题的时候,大概就这么一个过程感知,然后经过思考以后执行,大概就这么一个过程。

回顾历史上的几次工业革命,看他们解决了什么问题?

我们首先看到的是工业革命,通过机械化和电力化,还有自动化,它主要解决的是我们体力延伸,比如起重机可以把很重的东西举起来,比如火车、汽车、轮船、飞机等交通工具可以跑得很快,那么当然还有很多的提升我们体力的这种东西。

而过去的半个多世纪,我们迎来了信息革命,主要是对我们感官的延伸,也就是我们的感知能力得到延伸。比如,眼睛看得更远了,说话的声音传得更远,我们听得更远,我们的皮肤能感受的更远。

显然,过去工业革命、信息革命并没有解决我们现在大脑的问题,而现在出现的智能化的革命,其实正在尝试着解决我们的大脑,也就是延伸我们的认知,对我们的认知能力将是一个巨大的提升。

那么谈到这次智能化,我们不得不回顾一下上世纪40年代,那个时候还是有很多新的东西诞生,除了计算机之外的人工神经网络的概念给提出来了。我们看到麦克罗尔和皮茨两个人,一个是生物学家、一个是数学家,他们搞清楚了人脑神经元的模型。

但是这个模型出来以后很长时间没有什么太大的突破,一直到上世纪的80年代,加拿大的神经学家Hubel搞清楚了我们视觉神经的基本工作原理,那么才带来了我们今天这次深度学习的一次重大的一种进步。

iRobot董事长兼CEO科林·安格尔曾说过一句话,“观察全社会将如何对待人类智能技术将会很有趣,这一技术无疑会很酷。”其实应该说,我们已经开始进入智能化时代,这是一个非常令人激动的这样一件事情,当然它对我们社会人类社会影响,今天还没有完全看到,未来肯定是会巨大的。

计算技术驱动半导体产业不断成长

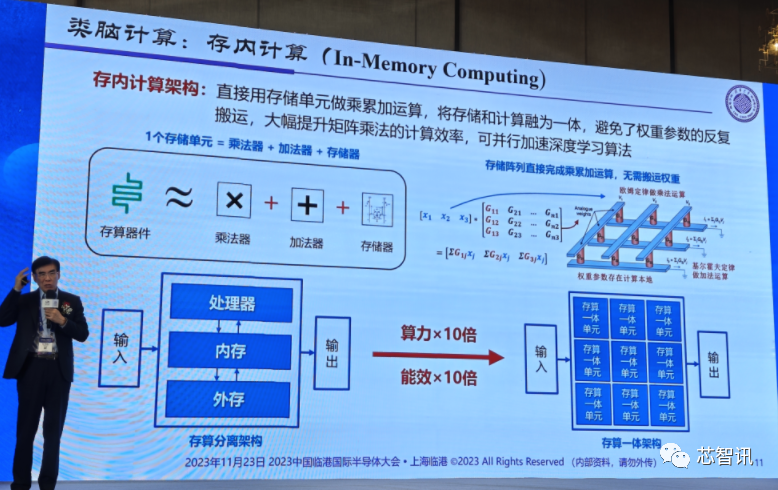

现在人工智能大概分两类,一类叫类脑计算,一类是深度学习。类脑计算主要是想模拟我们人脑的一些工作原理,比如最典型的存内计算,可以用来加速我们的人工智能的运算能力,可以带来比传统的算力提升10倍、能效提升10倍的效果,这是非常高的一个数字。

而深度神经网络和深度学习则是另外一个分支。2018年的三位图灵奖获得者,他们更多的是做了一个数据化,把神经网络或者神经元的比作一个节点,然后把一些互联比作神经元的突触,一些互联就是节点之间的互联,然后把它展开,甚至展开的时候不仅是一维的展开,还有二维的展开,变成一个非常复杂的深度学习神经网络,然后通过对神经网络的训练,能够尝试得出一些地方的权重的不同,这些边的权重就决定了它的基本模型,经过大量的训练以后,模型就固定下来。

对于深度学习的发展,有三个影响因素:一个是算法、一个是数据、一个是算力。算法就是神经网络的构成,数据是现实社会当中的数据,我们要把大量的数据喂给它,通过训练以后让它得到我们想要的结果,这一过程需要依赖于算力来实现。

谈到计算的话,我们就不得不去回顾一下计算技术在过去的发展当中,对我们半导体产业来说意味着什么?

我们可以看到半导体产业是在持续增长,但是我们也可以非常清楚的看到,在过去的二三十年三四十年的时间当中,其实我们经历了好几个不同的时代。比如说我们早期的科学计算时代,后来的个人计算时代、移动计算时代、云计算时代,现在大家我们进入了智能计算时代。

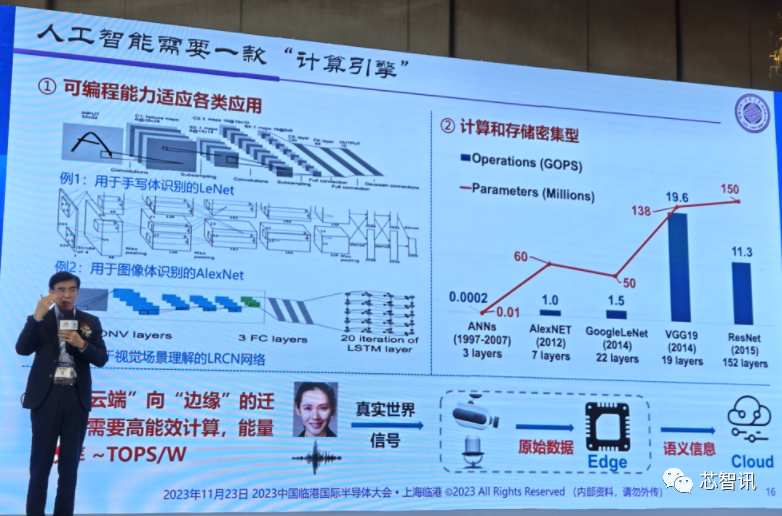

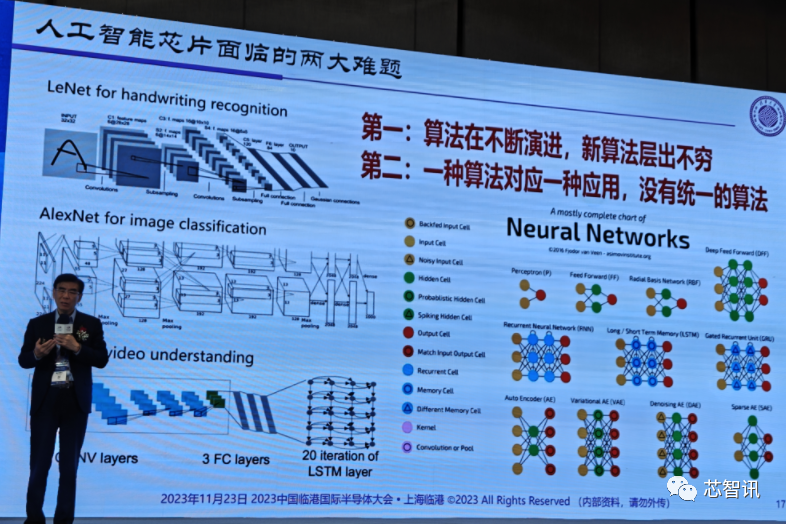

那么智能计算时代它有几个基本特点,首先就是它是跟人工智能密切相关的,人工智能由于算法多样性和复杂性,所以我们看到一个很有趣的现象,每一种算法其实跟另外一种算法是不一样,即便他要处理的事情比较相近。比如说我们用人眼去识别文字、图像、视频的内容,都是用眼睛去看,但它的算法是不一样。

第二个,它是一个计算和存储高度密集的。比如说2014年的VGG19模型是一个19层的模型,对于现在来说这只是一个小模型,它依然需要每秒钟196亿次的算力,同时运算还会涉及到1.38亿的参数,这是一个非常大的参数,非常高的运算能力,因此它对存储对计算双重要求。

当然,这还只是在云端的需求,解决算力和存储就可以了。但是,如果要把它用到我们手机端、边缘端的话,还将面临一个能效的问题。所以,我们还必须把能效提升,否则手机去用这个东西很快就没电了。

因此,我们在碰到这些问题的时候,要回归到最早的,我们就为什么会出现这种状况?原因很简单,就是人工智能还在两个方面不停的向前演进。

第一个就是,算法的不断演进。目前人工智能新算法层出不穷,每过几个月它可能就会变一次,这个变化太快了。

第二个就是,目前没有统一的通用算法。比如刚才我讲的这个例子,一个眼睛对应的三个不同应用的时候,它可能是三个算法,而不是一个统一的算法。

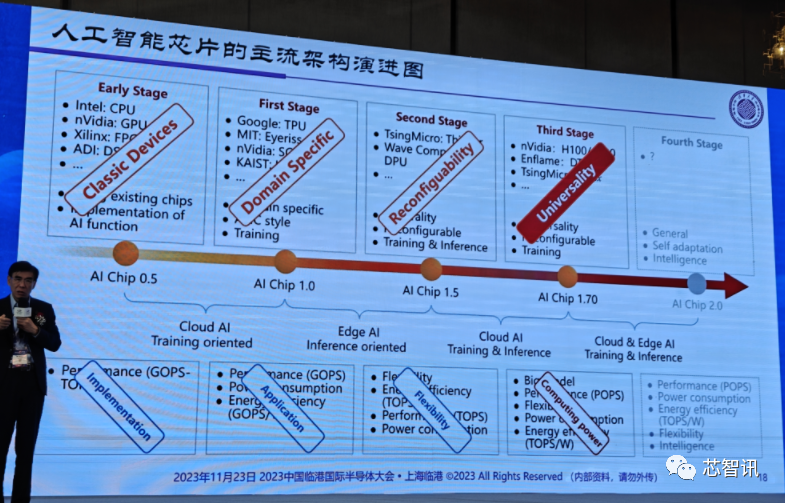

在这种情况下,人工智能芯片做起来就会比较困难。事实上,AI芯片的发展过程当中,也是经过一系列的持续演进过程的。

最早的时候,我们是没有人工智能芯片的,因此我们的最重要的就是找已经有的芯片我来把它实现就好。后来发现传统芯片实现人工智能的效率太低,怎么办?一些企业开始做专用芯片,这个称为叫DSA,面向应用定义的芯片架构。再往后,我们发现一个应用就来定义一颗芯片实在太费劲了,能不能让一颗芯片去适应不同的应用,那么出现了可重构芯片,可以带来更高的灵活性,让一个芯片可以灵活适应不同的算法。

本来到这儿的话,我们觉得下一步应该差不多结束了,结果没想到以ChatGPT的大模型的火爆,带动大算力通用芯片的需求的爆发。大家折腾一圈后,最后发现我们实际上还是算力不够,相比目前的生成式AI大模型,原有的人工智能应用显得非常的苍白无力。

本来我觉得AI芯片从1.5到2.0就结束了,现在我不得不在中间又加了了1.7,这个阶段解决的就是通用性AI计算的问题。为什么英伟达的 GPU这么受欢迎,就是因为它不是专用的,它通用性带来的好处是,各种各样的AI模型都可以训练,因此大模型用它的芯片去训练会带来非常明显的便利性。所以我们经常讲的通用为王,在AI芯片这个地方又再次体现出来了。

当然我不认为这个过程当中,算力就能把所有问题解决。我认为现在大算力仍然只是人工智能发展当中的一步,我们最终还是要解决功耗问题,把这个东西推到我们的手机上,推到我们各种终端上,才能真正实现我们所谓的智能化。

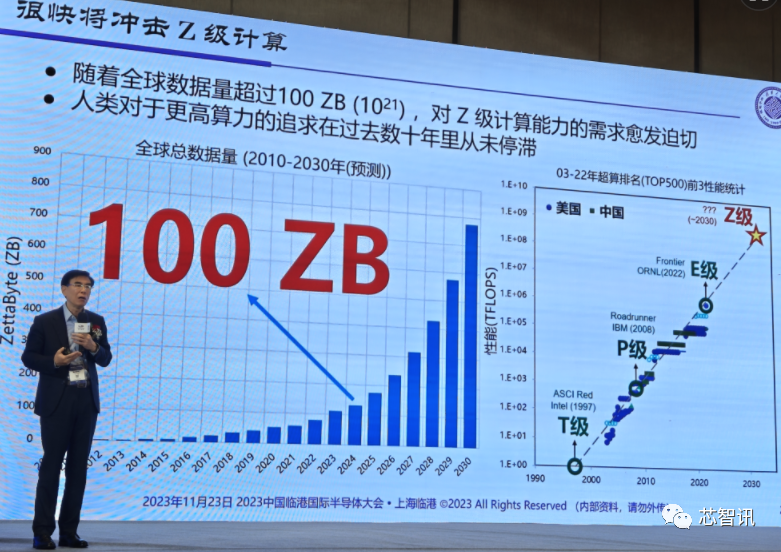

另外,我们看计算机的发展走到一个很有趣的现象,就能耗和互联的问题。比如,去年美国能源部发布的第一台E级超级计算机Frontier,其算力可以达到每秒10个18次方计算,即每秒100亿亿次计算。之后,美国马上就宣布了下一个目标——Z级超算,即每秒可以计算10万亿亿次,比现在的E级超算的算力要大1000倍。

为什么要去研发这么大算力的超算?因为我们是有实际需求的,因为我们的数据仍在不断的增长,预计到2024年的话,我们的数据大概就可以达到100ZB,实际上比我们计算能力增加更快,我们计算能力的增长已经快跟不上数据的增长了。

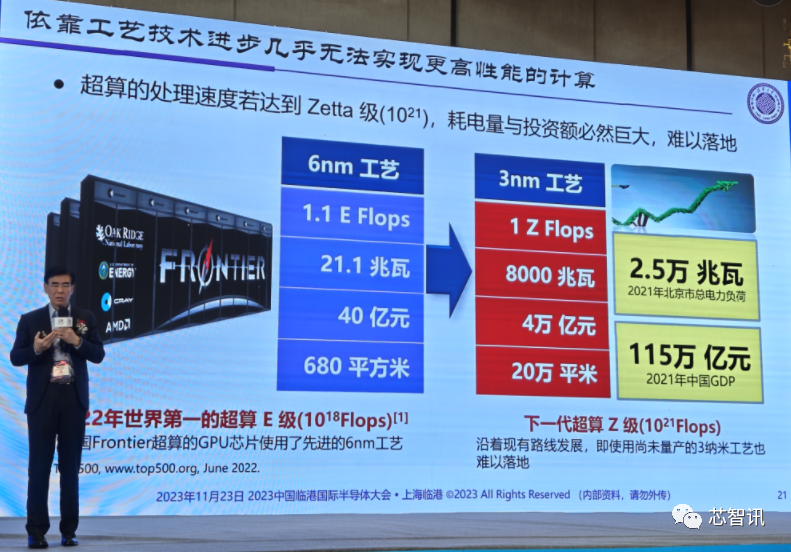

但是,我们如果想要去做一个Z级超算的话,现在面临的困难将会是非常多的。比如说目前的E级超算的很多计算芯片是基于台积电6nm工艺的,达到1.1E Flops的算力,那么它的能耗是21.1兆瓦,即21100千瓦,也就是用一个小时耗电21100度,总体的造价6亿美元(大概42亿人民币),总体占地面积680平方米(超算实际占地面积是300多平方米,同时还有一些辅助的东西需要更多空间)。

所以,如果要将这个E级超算的算力提升1000倍,这个数据会怎么样?当然,它肯定不再用6nm芯片,可能会要用3nm获是更先进的芯片。我们用3nm来推演一下,我们就会发现要做Z级超算大概需要耗资6000亿美元(约4.2万亿人民币),占地面积需要20万平方米,能耗将会达到8000兆瓦,即一小时耗电800万度,按照现在工业用电7毛钱左右来计算,运行一小时就需要560万元。

作为对比,2021年中国GDP也就是115万亿人民币,所以它占了3.5%的样子,占地面积20万平方米,甚至可能更大到50万平方米,几乎要接近一个平方公里级了。果真如此的话,这个数据从这头跑到头跑到那头那么长的距离,它的延迟将会非常大。所以超算很难做到这么庞大的规模。

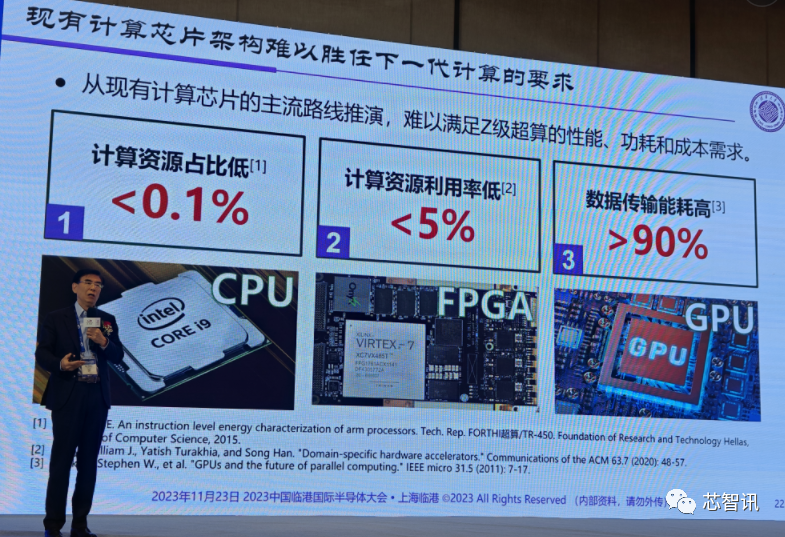

原因很简单,现有的计算架构当中,它的计算资源占比非常低,它的计算资源的利用率非常低,它的数据传输能耗也非常高。

显然,我们如果按现有的计算架构方式走下去,很难去胜任未来我们的人工智能算力要求,所以我们需要一个新的计算架构。

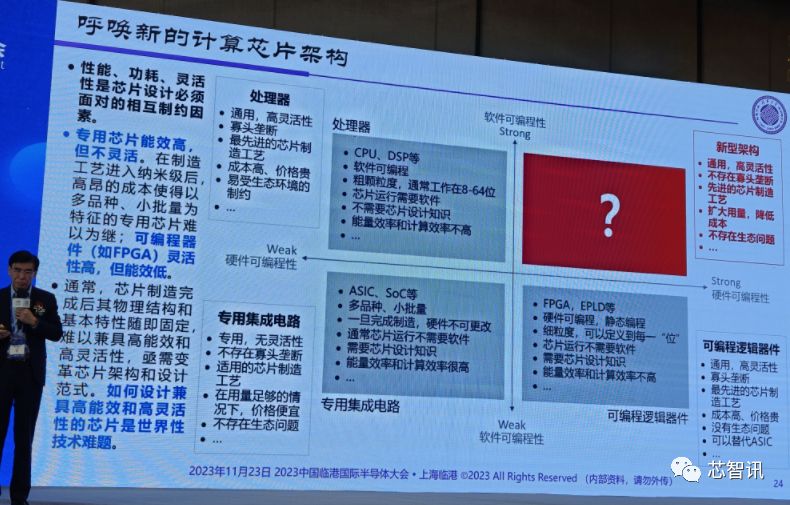

对此,我把硬件的可编程性和软件的可编程性分别作为横轴和纵轴,然后变成一个看4个象限,然后把现在芯片CPU、DSP这些东西放到第二象限里面去。那么ASIC等就进入了第三个象限,而FPGA、EPLD等等就进入了第四个象限,我们现有的芯片都放进去了,唯一一个空白的是第一象限,是硬件可编程、软件可编程两个都要有,这个可能就是我们需要去探索的一个领域。

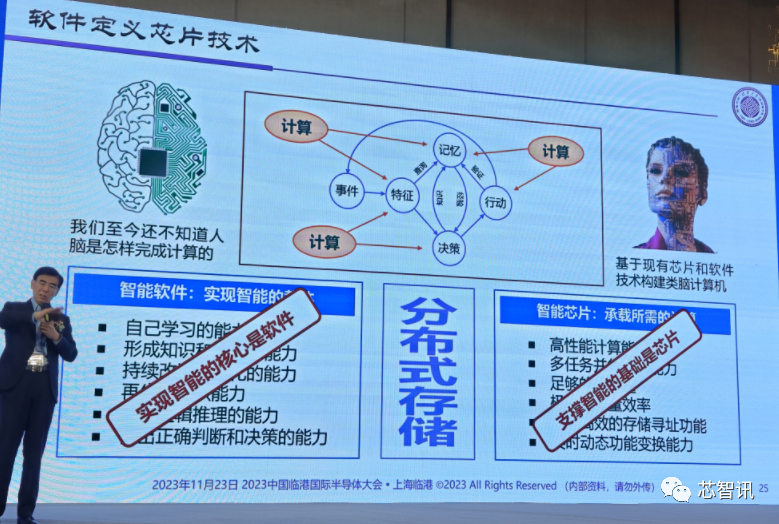

我们知道人脑是怎么工作的现在还没有完全搞清楚。现在模拟人脑这些功能的时候,还是要用计算机来实现,而计算机实现的时候就一定有芯片和软件。芯片是计算的主体,所以它承载的是计算,是支撑智能的基础,但真正能够实现智能的其实软件,所以我对软件的看法发生很大的变化,这里面其实软件有很多的创新点,比如说自学习的能力,即持续的改进和优化的能力,光这一点就很难,你一个软件装进去,它在不断的自己改进,能做到现在还做不到再生和组织能力等等。但是现在软件、硬件还是分离的,所以要把软件和硬件两者结合到一起,让它形成一种完整的全新的架构的时候,我们称其为叫软件定义的形式。

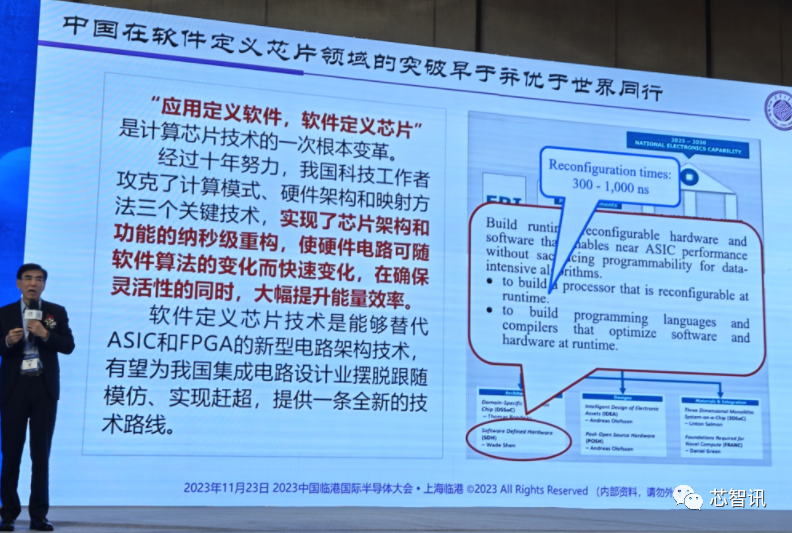

这个软件定义芯片,国际上一直在做,比如说美国2018年DARPA的ERI计划中,就有一个软件定义硬件项目。那么他花了7,100万美元,去年年底结题了。同样,欧洲地平线计划也有在做软基站,也是想做这件事情。那么这两两个项目做下来,应该讲虽然很好,还是有些进步,但是它没有摆脱原传统的计算机架构的影响,相比之下我们中国在这方面做的工作应该比他们要更好一些。

全球半导体产业大变局

我们看到了人工智能的变化,计算机的变化都离不开半导体。目前国内的半导体产业所面临的国际形势比较糟糕,比如美国对于全球半导体供应链破坏,包括美国Chip4联盟,美日荷三国对中国的半导体封锁,美国、欧盟、日本、印度等都都出台了自己的芯片法案或激励政策,都强调要生产本地化,要自给自足,形成自己的半导体产业链,前提是保证自己的产业安全。

大家可以想象一下,原来半导体产业是个全球化的市场,大家都是干自己擅长的,现在全球化的市场不再,各国都展开了半导体军备竞赛,但这不是真正市场驱动的。台积电创始人张忠谋先生此前就曾表示,全球化几乎已死,而且不太可能恢复。对这个问题我也比较悲观。

智能化助力中国半导体产业自立自强

那么我们该怎么去做?我觉得智能化可能对中国来说是一个非常重要的点。

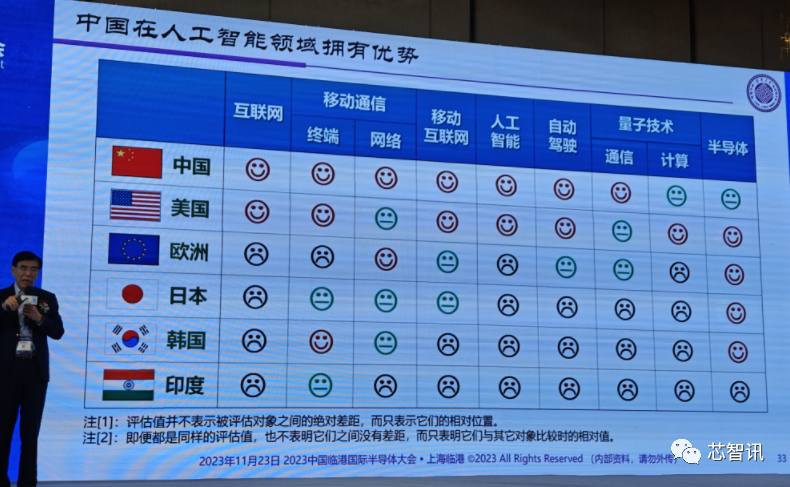

第一个就是,我们在人工智能领域拥有的优势并不比别人差。这个地方我把主要大国和在信息领域当中的一些情况对比较用一个笑脸表示,我们做的不错,用一个哭脸表示我们做的不好。那么这个情况大家看到了,事实上我们在人工智能上相比起其他国家,中美两国是最好的,我们跟美国之间竞争说各有长处。

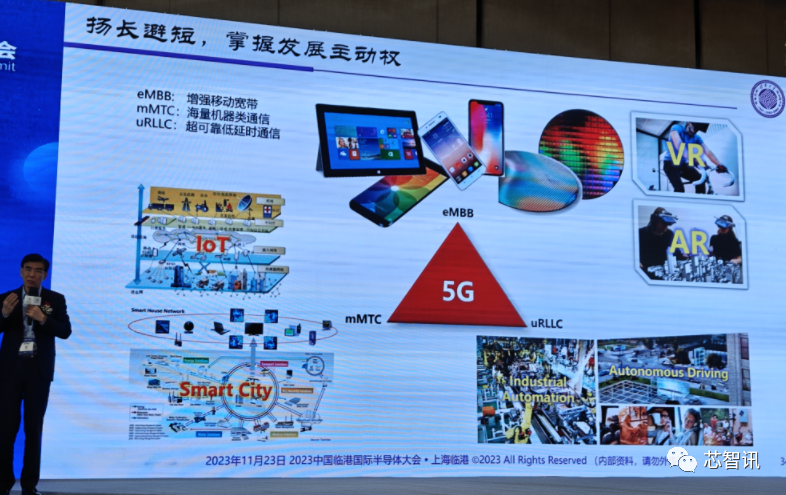

第二个就是,我们在基础设施当中,比如说5G的发展当中有很多的优势,这些优势其实构建了一个很好的结果。中国目前拥有的5G基站的数量是世界其他国家的总和,因此我们在国内现在感受到5G的网络的使用远好于其他国家。

所以,我们需要扬长避短,掌握发展主动权。得益于我们在AI和5G方面的优势之外,我们可以依托这两项优势来发展应用端创新,比如发展AR/VR、智慧城市、IoT等。

此外,我们还可以开辟车规芯片新赛道。根据中国汽车工业协会统计数据,我们的燃油车的芯片平均数量已经涨到了930多个,我们的新能源汽车的芯片平均数量已经涨到了1,460个,目前中国有3,000万辆汽车的产能,但是我们自己国产车规芯片却很少。面对国内这么大的汽车芯片市场需求,如果都能用上国产芯片,这将是一个巨大的机会。但是,做车规芯片非常难,也需要很长的时间积累,也需要我们有足够的耐心。

另外,如果我们要打造一个智能汽车,就要有自己的数据处理平台。因为每个车厂都不愿意把自己的数据给另外一个车厂用。这样的话我们其实就要构建一个真正的具有信息安全和隐私保护的智能计算平台。

在高性能计算方面,虽然我们的先进制程发展受限,但是我们可以利用三维混合键合技术、先进封装技术,来解决算力问题和存储的带宽问题。比如,原来我们是把芯片做好了,切割下来再去封装,现在我们把逻辑线路和存储电路两个晶圆面对面的放到一起,然后再把它切开再去封装,我们觉得这种做法,其实用封装技术的方式来解决我们现在面临的问题。我们可以看到如果把逻辑层跟存储器的这两层技术,加上我们中国自己做的软件定义芯片技术,其实我们是可以解决我们当前计算当中的很多问题,当然还有一新的创新的进程。所以这点我觉得我们还是要有信心,不是说我们都要去靠最先进制程来提升算力。

结语:

最后我还是想大家对半导体有信心,对摩尔定律有信心。

摩尔定律经常会有人说“摩尔定律已经失效”。早在1997年的时候,就有一个人就说“摩尔定律大概不灵了”。他举了三个例子,一个是材料,用铝、铜污染太大不行;一个是器件的结构漏电太厉害,大概能做到50纳米撑死了;还有一个最重要的就是光刻技术的193纳米的波长,最多也就做到100纳米。所以他认为摩尔定律差不多到头了。后来我们知道,用大马士革的镶嵌技术,我们解决了投互联的问题,后来又还可以金属包裹金属栅极解决漏电问题。还有光刻机波长的问题,后来ASML推出了浸没式193nm光刻机,仅在镜头和硅片加入了超纯水,就成功支撑了半导体制程10代的发展。

那么这个对于“摩尔定律”预判错误的人是谁呢?是戈登·摩尔本人。20多年前(1997年)他也看错了趋势,所以现在如果有人说半导体快不行了,千万别信他的话,我觉得我们还有更为很光明的未来。

编辑:芯智讯-浪客剑