8月27日消息,据摩根士丹利最新公布的一份报告显示,虽然目前人工智能(AI)芯片市场竞争激烈,但是英伟达依旧是无可争议地占据着市场主导地位,并且其产品的经济效益也远超其他竞争对手。

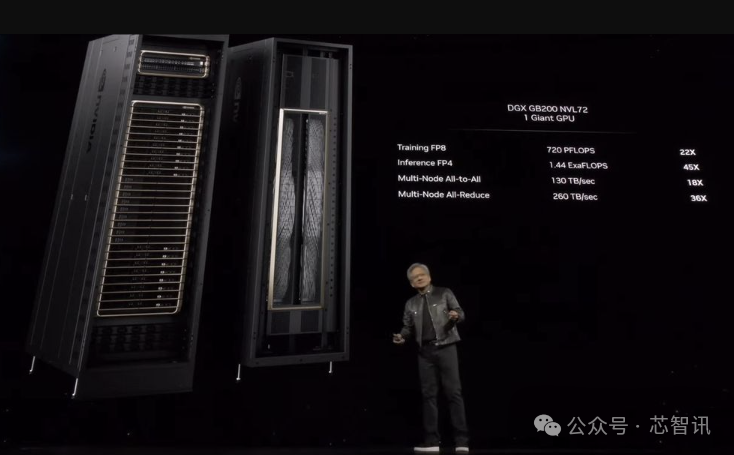

报告以英伟达目前畅销的GB200 NVL72机架为例指出,这个机架包含了72个NVIDIA B200 GPU和36个Grace CPU,通过NVLink互联,整体的成本约为310万美元。而上一代的8卡配置的H100服务器架构仅为30万美元左右。不过,对于大型的 AI工厂(数据中心),摩根士丹利认为,与上一代的H100相比,采用英伟达最新的GB200 NVL72机架式产品更具经济效益。

根据摩根士丹利的计算,对于给定的100MW规模的AI工厂,尤其对于专注于推理的AI工厂来说,英伟达的GB200 NVL72系统目前在盈利能力方面居于市场领先地位,其次是谷歌的TPU v6e pod。

具体来说,100MW规模的AI工厂,使用英伟达的GB200 NVL72 机架,该AI工厂可以实现77.6%的利润率;而如果实使用谷歌的TPU v6e pod则可以实现74.9%的利润率。需要指出的是,虽然谷歌TPU v6e pod的定价尚未公开,但是与英伟达GB200 NVL72机架相比,租用谷歌TPU v6e pod的平均成本要低40%至50%。

△将CoreWeave平台的每小时每芯片的收入与每小时每GPU(GB200 NVL72)的租金价格进行比较

有趣的是,根据摩根士丹利的计算,采用AMD MI300和MI355平台的100MW规模的AI工厂的利润率为负,分别为-28.2%和-64%。英伟达GB200 NVL72 机架为AI工厂所带来的利润率却是最高的,达到了77.6%。这还是真是印证了英伟达CEO黄仁勋那句广告语:“买得越多,省得越多!”

摩根士丹利的报告基于一个假设,即一个100MW的AI工厂需要6.6亿美元的基础设施成本,在10年内折旧。GPU的成本从低端的3.67亿美元到高端的22.73亿美元不等,折旧期为4年。然后,摩根士丹利通过将各种冷却系统提供的能效应用于全球电价的平均值来计算运营成本。最终,计算出各芯片能够为AI工厂带来的利润率。

虽然,对于100MW规模的AI工厂(利用Llama 2 70 B模型进行推理)来说,英伟达GB200 NVL72能够带来更好的经济效益,但是其总拥有成本(TCO)也是最高的,达到了8.0658亿美元。相比之下,AMD的MI355X平台则略低,为7.7411亿美元;谷歌的TPU v6e pod的TCO最低,只有3.5869亿美元。

编辑:芯智讯-浪客剑