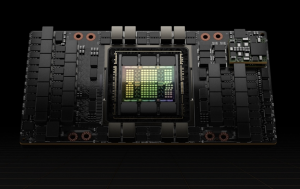

7月23日,美国人工智能初创企业xAI CEO埃隆·马斯克(Elon Musk)宣布,xAI 计划在未来五年内部署相当于5,000万个英伟达(NVIDIA)H100 等级的AI GPU,这一目标不仅在规模上超越当前的AI 硬件标准,还将在能效上有显著提升。

50 ExaFLOPS 用于 AI 训练

虽然5000万个英伟达H100的数量看起来很多,但考虑到这里指的是“等效算力”,这也意味着如果xAI未来五年持续采用最先进的GPU,可能只需要不到100万个左右就能够实现。

目前一个英伟达H100 GPU 可以为 AI 训练提供大约 1,000 FP16/BF16 TFLOPS(这些是目前最流行的 AI 训练数据格式),因此到 2030 年,5000 万台此类 AI 加速器将需要提供 50 个 FP16/BF16 ExaFLOPS算力用于 AI 训练。根据当前的性能改进趋势,这在未来五年内是可以实现的。

需要65万个Feynman Ultra GPU

假设英伟达(或其他AI芯片公司)将继续以略慢于 Hopper 和 Blackwell 的升级速度扩展其 GPU 的 BF16/FP16 训练性能,那么预计到 2028 年将使用 130 万个 最新的GPU 或 2029 年使用 65万个最新的GPU。

如果 xAI 有足够的钱花在英伟达最新的AI芯片上,甚至有可能更早实现部署 50 ExaFLOPS 的AI算力的目标。

目前马斯克 的 xAI 已经部署最新 AI GPU 加速器,以提高该公司的AI训练能力,其 Colossus 1 超级集群使用了 200,000 个基于 Hopper 架构的英伟达H100 和 H200 加速器,以及 30,000 个基于 Blackwell 架构的 GB200 加速器。

此外,xAI接下来的目标是构建由 550,000 个 GB200 和 GB300 节点组成的 Colossus 2 集群(每个节点都有两个 GPU,因此该集群将配备超过 100 万个 GPU)。据马斯克透露,第一批节点将在未来几周内上线。

性能稳定提升

英伟达(和其他公司)新的 AI 加速器的更新节奏现在转向了每年一更新,而具体产品的性能升级幅度类似于英特尔过去的 Tick-Tock 模型,即一年小升级,一年大升级。例如,Blackwell后续是Blackwell Ultra,再接下来是Rubin,后续是Rubin Ultra。

这种方法确保了每年性能的显著提高,从而确保了长期性能的显著提升。例如,英伟达声称其Blackwell B200的推理性能比2016年Pascal P100高出了20000倍,提供约20000个FP4 TFLOPS性能,而P100的性能只有19个FP16 TFLOPS。虽然不是直接比较,但该指标与推理任务相关。当以每生成一个Token的焦耳数来衡量时,Blackwell的能源效率也是Pascal的42500倍。

事实上,英伟达和其他公司并没有随着性能的持续提高而放缓性能提高的速度。例如,Blackwell Ultra架构(B300系列)在人工智能推理方面的FP4性能(15 FPLOPS)比原始Blackwell GPU(10 FPLOPS)高出50%,在人工智能训练方面的BF16和TF32格式性能高出两倍,但INT8、FP32和FP64性能较低。作为参考,BF16和FP16是用于AI训练的典型数据格式(尽管FP8似乎也经过了评估),因此可以合理地预期英伟达将通过其下一代Rubin、Rubin Ultra、Feynman和Feynman Ultra GPU来提高这些数据格式的性能。

根据计算,英伟达H100的FP16/BF16的性能相比A100提高了3.2倍,然后B200相比H100性能又提高了2.4倍。当然,实际的训练性能不仅取决于新GPU的纯数学性能,还取决于内存带宽、模型大小、并行性(软件优化和互连性能)以及FP32的累积使用。然而,可以肯定地说,英伟达可以通过每一代新一代的GPU将其训练性能(FP16/BF16格式)提高一倍。

假设英伟达可以通过基于Rubin和下一代的Feynman架构的四代后续AI加速器实现上述性能提升,那么在2029年的某个时候,大约需要65万个Feynman Ultra GPU才能达到大约50个BF16/FP16 ExaFLOPS。

耗电量巨大

尽管马斯克的xAI和其他人工智能领导者可能会在未来四五年内获得50 BF16/FP16 ExaFLOPS用于人工智能训练,但最大的问题是这样一个超级AI集群将消耗多少电力?

一个H100 AI加速器功耗大约700W,因此其中5000万个处理器将消耗35吉瓦(GW),相当于35座核电站的典型发电量,这使得今天为如此庞大的数据中心供电变得不现实。即使是Rubin Ultra的集群也需要大约9.37吉瓦的电力。假设Feynman架构使BF16/FP16的每瓦性能比Robin架构翻了一番,一个50 ExaFLOPS集群仍将需要4.685 GW的电力,这远远超过了xAI的Colossus 2数据中心所需的1.4 GW-1.96 GW。这一需求将对美国当前的能源基础设施提出严峻的挑战。

编辑:芯智讯-浪客剑