两年前,谷歌推出了旗下的首款张量处理器(Tensor Processing Units),即TPUs。这种芯片可以用在公司数据中心里,专门负责一些人工智能数据处理工作。

但是随着物联网的发展和边缘计算的需求,现在谷歌正在将他们的人工智能计算经验从云端往下搬,推出了新的Edge TPU(边缘计算 TPU)。Edge TPU是一个体积很小的人工智能计算加速器,有了它,物联网设备就能拥有处理机器学习任务的能力啦!

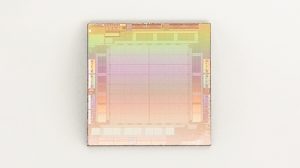

谷歌新推出的EdgeTPU放置在一个一美分硬币之上

Edge TPU主要是为了处理所谓“推断”类的机器学习任务。“推断”是在整个机器学习的过程中,被训练好的模型执行任务的阶段,比如从一张图片里识别出某种物体。谷歌之前推出的服务器端的TPUs主要是负责训练模型的,现在推出的这个Edge TPUs主要是负责使用训练好的模型进行“推断”任务的。

Edge TPUs是注定要用在企业场景中,而非咱们的智能手机里。比如,企业工厂生产场景中的自动质量检查工作就很适合Edge TPUs。相对于通过硬件设备采集数据然后通过网络发送给服务器进行分析的传统方法而言,在物端直接执行智能分析的方法有很多优势,包括物端机器学习更能够保障安全性,等待和停机的时间更短,决策速度更快等。(这些优势是目前物端机器学习的卖点)

Edge TPU是TPU的小兄弟,TPU是谷歌公司用来加速人工智能计算的专用处理器,其它消费者能够通过买谷歌云服务来使用这项技术。

谷歌可不是唯一一个做这样物端人工智能芯片的公司。ARM、Qualcomm 、Mediatek和其它很多芯片厂商都在做自己的人工智能加速器,英伟达(Nvidia)的GPUs还是市场上最著名的人工智能模型训练芯片。

然而,谷歌的优势是控制全栈人工智能计算硬件产品与服务市场,而竞争对手们并没有做到。用户可以将数据存储在谷歌云服务,可以通过TPUs训练自己的算法,可以使用Edge TPUs进行最终的物端机器学习推断。谷歌还将会通过自行创建和运营的一款编程框架TensorFlow来开发机器学习软件。

这种“什么都是我们家”的垂直一体化形式(vertical integration)有明显的优势。谷歌能够保证系统中的每个部分间的通讯尽可能有效和流畅,使用户能够在谷歌的生态系统中操作得更容易、使用得更方便。

“你的传感器将不再仅仅会无脑采集数据啦”

谷歌云的物联网部门副总裁Injong Rhee在一篇博客中将这种新硬件形容成“一种专门用来在物端跑轻量级Tensorflow和机器学习模型的ASIC芯片”。Rhee说:“Edge TPUs是用来补足和完善我们云端TPU产品的,有了它,你就能够在云端用TPU加速机器学习模型的训练,然后在物端的设备还能有轻量级还快速的机器学习决策能力。你的传感器就不光是一个数据采集终端了,它们还能进行本地化、实时性的智能决策任务。”

来源:大数据文摘 编译:Don FJ、陈同学、蒋宝尚

博客链接:

https://blog.google/products/google-cloud/bringing-intelligence-to-the-edge-with-cloud-iot/

有趣的是,谷歌也将Edge TPU当作一个开发套件提供给消费者,这样一来消费者就能轻松地测试硬件性能,也能知道到底Edge TPUs是否适合他们的产品了。这个开发套件中包括一个SOM(System on module,模块化系统),SOM中就包括了Edge TPU芯片,还有一个NXP的CPU,一个小型化安全单元。SOM也配备Wi-Fi通讯功能。SOM能够通过USB或者PCI-E的方式和咱们的计算机进行连接。这套开发套件现在还是处于beta状态,而且需要用户申请才能试用。

申请链接:

https://cloud.google.com/edge-tpu/

在谷歌的发布新闻中,有一点虽然看似不起眼,但是很耐人寻味。按照谷歌的脾气,一般不会让公众染指其人工智能硬件部分。但是如果谷歌想让消费者真正能够使用这个技术,那肯定需要让大家先试试它,而不是靠着谷歌振臂一呼就让大家坚信“谷歌大法好”,扎入谷歌人工智能大家庭的怀抱(AI Googlesphere)。这个开发板不只是为了吸引同行者,它更是表明了谷歌对于整个AI计算产品和服务市场的觊觎之心和严肃态度。

相关报道:

https://www.theverge.com/platform/amp/2018/7/26/17616140/google-edge-tpu-on-device-ai-machine-learning-devkit